Cours

L'intelligence artificielle évolue si rapidement que suivre le rythme des défis liés à l' sde sécurité revient à tenter de réparer un avion en plein vol. À mesure que les systèmes deviennent plus intelligents et s'intègrent davantage dans les processus opérationnels quotidiens, ils deviennent également plus vulnérables à de nouveaux types de menaces.

J'ai pu observer cela de près dans le cadre de mon travail. À plusieurs reprises, j'ai identifié des failles de sécurité dans les processus opérationnels qui auraient pu permettre à des personnes non autorisées d'accéder à des informations sensibles, en particulier lorsque des solutions d'intelligence artificielle ont été mises en œuvre de manière précipitée sans que les mesures de sécurité appropriées aient été mises en place.

C'est le sujet de cet article : comprendre les risques, les défis et les meilleures pratiques pour garantir la sécurité de l'IA. L'IA évolue à un rythme soutenu, et si nous ne prenons pas les devants face aux vulnérabilités, nous risquons de perdre la confiance et les avantages qu'elle apporte.

Si vous souhaitez approfondir ce sujet, je vous recommande de consulter la section cours sur la sécurité et la gestion des risques liés à l'IA .

Nouveaux défis en matière de sécurité liés à l'intelligence artificielle

L'intelligence artificielle fonctionne à partir de données. Et plus votre IA s'appuie sur un volume important de données, plus la cible est importante. Les pirates informatiques sont conscients de cela. Veuillez imaginer un hôpital utilisant l'intelligence artificielle pour prévoir les risques pour la santé des patients. Cela semble parfait, jusqu'à ce que quelqu'un pirate le système. Soudainement, les dossiers médicaux privés sont accessibles sur le dark web, ou pire encore, les données médicales sont modifiées, ce qui peut entraîner des décisions préjudiciables. Le chiffrement des données sensibles et la réalisation de sauvegardes sont essentiels, mais de nombreuses entreprises sont tellement axées sur l'innovation qu'elles négligent ces principes fondamentaux.

Par ailleurs, les pirates informatiques ne se contentent pas de voler des données. Ils peuvent manipuler les modèles d'IA eux-mêmes. Par exemple, une voiture autonome qui serait amenée à confondre un panneau « Stop » avec un panneau de limitation de vitesse. Ce type d'attaque est appelé attaque par empoisonnement des données, dans laquelle les pirates informatiques introduisent des données erronées dans le système afin de fausser ses décisions. Nous examinerons ce point plus en détail dans la section suivante.

Les attaques par injection rapide constituent un autre type d'attaque. Il s'agit de manipulations subtiles qui incitent une IA à dire ou à faire quelque chose qu'elle ne devrait pas. Nous avons un excellent article sur l'injection de prompt, nous n'entrerons donc pas dans les détails dans cet article, mais nous vous recommandons vivement de le lire.

Il est intéressant de noter que les pirates informatiques utilisent également l'IA pour mener à bien leurs attaques. C'est là que la cybersécurité devient une course contre la montre : les pirates informatiques innovent et les équipes de sécurité doivent réagir tout aussi rapidement. Des outils tels que la détection des anomalies peuvent être utiles, mais ils ne sont pas infaillibles.

Avez-vous déjà entendu l'expression « Une chaîne n'est aussi solide que son maillon le plus faible » ? Cela s'applique parfaitement à l'IA. Les entreprises intègrent fréquemment des outils d'IA pré-conçus dans leurs systèmes. Cependant, que se produit-il si l'un de ces outils est compromis ? Imaginez qu'un chatbot populaire utilisé par de nombreuses entreprises soit piraté. Cela représente des centaines d'entreprises, ainsi que toutes leurs données clients, qui sont exposées à des risques. Il s'agit d'un effet domino numérique.

Enfin, il y a le déficit de compétences. L'adoption de l'IA est en hausse, mais la cybersécurité pour l'IA est toujours en retard.

Menaces pour la sécurité liées à l'intelligence artificielle

Les systèmes d'IA sont confrontés à de graves menaces de sécurité qui peuvent compromettre leur efficacité et leur fiabilité. Examinons les principales menaces.

Attaques adversaires

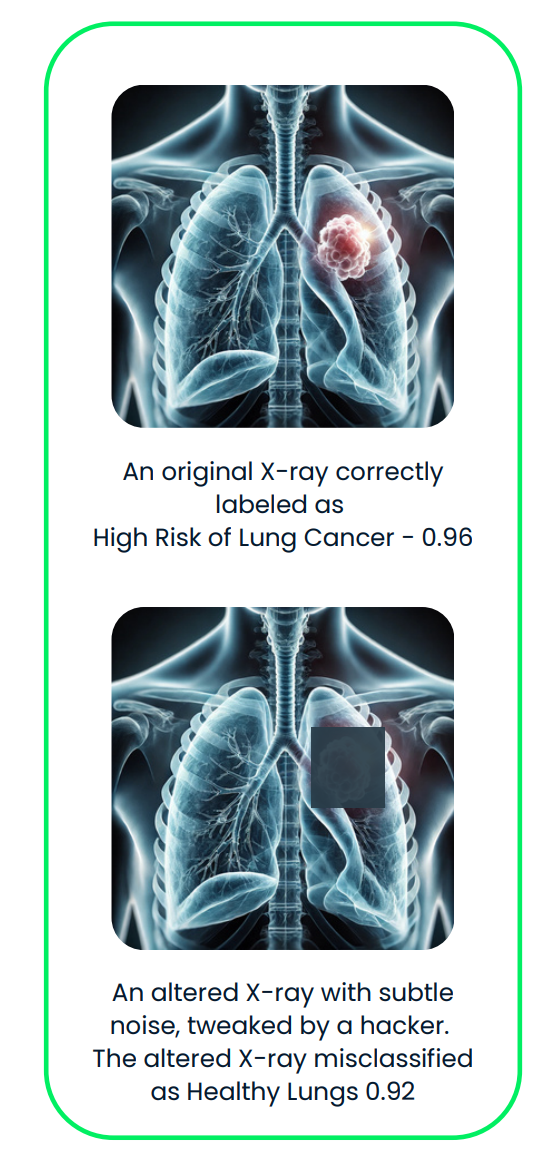

Les attaques adversaires trompent les systèmes d'IA en apportant de petites modifications subtiles aux données traitées par l'IA. Ces changements sont si subtils que les humains ne les remarquent généralement pas, mais ils peuvent complètement induire l'IA en erreur et l'amener à prendre une mauvaise décision.

Par exemple :

- Modifier de petits détails dans une image, comme quelques pixels, afin que l'IA l'identifie de manière erronée.

- Ajouter un léger bruit à un fichier audio, ce qui le rend identique à nos oreilles, mais induit l'IA en erreur.

- Modifier la formulation d'une phrase afin de perturber la compréhension de l'IA.

Ces attaques ne nécessitent pas que l'attaquant connaisse le fonctionnement interne de l'IA, ce qui constitue une autre raison pour laquelle elles sont très difficiles à détecter et à contrer.

Examinons maintenant quelques exemples concrets.

- Algorithme DeepFool : DeepFool est une méthode conçue pour apporter des modifications minimes, presque invisibles, à une entrée, telle qu'une image, afin d'induire l'IA en erreur et de la pousser à la classer de manière erronée. Il fonctionne en ajustant progressivement les données d'entrée jusqu'à ce que l'IA commette une erreur. Ces changements sont si minimes que les êtres humains ne les remarqueraient même pas.

- Attaques audio ciblées : Dans ce document, article, des attaquants ont créé un fichier audio presque identique à l'original, mais qui fait entendre des mots complètement différents au système de reconnaissance vocale. Cette méthode a été employée pour tromper le système DeepSpeech de Mozilla avec un taux de réussite de 100 %.

- Manipulation du pilote automatique Tesla : Keen Labs a réussi à tromper le système de pilotage automatique de Tesla en plaçant stratégiquement trois autocollants discrets sur la route, ce qui l'a amené à mal interpréter les marquages au sol et à risquer de se diriger vers la mauvaise voie. Pour en savoir plus, veuillez consulter cette page.

Ce diagramme illustre une attaque antagoniste contre un système d'IA dédié à l'imagerie médicale. La radiographie originale, correctement classée comme « Risque élevé de cancer du poumon », est subtilement modifiée par un bruit antagoniste, ce qui entraîne une classification erronée comme « Poumons sains ».

Une lecture intéressante est Adversarial Machine Learning, un domaine qui étudie les attaques exploitant les vulnérabilités des modèles d'apprentissage automatique et développe des défenses pour se protéger contre ces menaces.

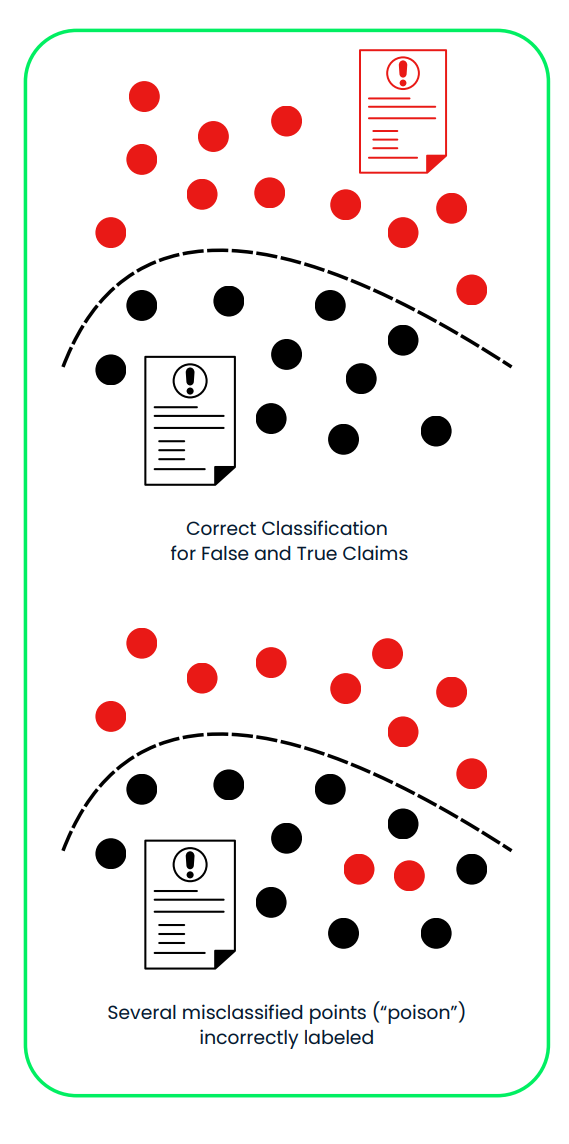

Attaques par empoisonnement

Les attaques par empoisonnement visent la phase d'apprentissage des systèmes d'IA, au cours de laquelle le modèle apprend à prendre des décisions. Les attaquants introduisent subrepticement des données corrompues ou trompeuses dans l'ensemble d'apprentissage afin de manipuler l'IA pour qu'elle se comporte de manière incorrecte ou favorise des résultats biaisés. Ces attaques sont efficaces car elles altèrent les fondements du processus d'apprentissage de l'IA, souvent sans laisser de signes évidents d'anomalie.

Cela peut impliquer :

- Modifier les étiquettes de certains exemples d'entraînement, par exemple en étiquetant une image de chien comme étant un chat.

- Ajouter de fausses données conçues pour influencer les décisions de l'IA de manière spécifique.

Ces modifications subtiles peuvent entraîner une défaillance de l'IA dans certaines conditions ou l'amener à agir d'une manière qui profite à l'attaquant. Étant donné que l'attaque se produit pendant l'entraînement, il est difficile de la détecter une fois le modèle déployé.

Examinons quelques exemples concrets :

- Attaques par porte dérobée : Une étude intitulée« » (Contournement des algorithmes de détection des portes dérobContournement des algorithmes de détection des portes dérobées dans l'apprentissage profond» (Contournement des algorithmes de détection des portes dérobées dans l'apprentissage profond) a démontré comment les attaquants peuvent dissimuler des « portes dérobées » malveillantes dans les modèles d'IA. Ces portes dérobées ne sont activées que dans des conditions spécifiques, par exemple lorsqu'un certain motif apparaît dans une image. L'étude a démontré que les attaquants peuvent utiliser des techniques avancées pour rendre les données corrompues identiques aux données saines, échappant ainsi à la détection.

- Contamination des ensembles de données à l'échelle du Web : Dans l'article intitulé« » (L'empoisonnement des ensembles de données d'apprentissage à l'échelle du Web est une pratique courante», les chercheurs ont décrit comment les grands ensembles de données collectés sur Internet peuvent être compromis :

- Contamination des données en vue fractionnée : Corrompre les données après leur collecte, mais avant leur utilisation pour la formation.

- Contamination des données par frontrunning : Manipulation des données juste avant leur ajout à l'ensemble de données.

- Le chatbot Tay de Microsoft : En 2016, Microsoft a déployé un chatbot nommé Tay sur Twitter. Les utilisateurs ont rapidement manipulé Tay en lui envoyant de nombreux messages offensants, ce qui l'a amenée à publier des tweets racistes et inappropriés. Microsoft a dû fermer Tay peu après son lancement. Pour en savoir plus, veuillez consulter cette page.

Ce diagramme illustre une attaque par empoisonnement sur un système d'IA utilisé pour classer les demandes d'indemnisation d'assurance comme fausses ou vraies. Dans le premier panneau, le système distingue correctement les déclarations fausses (rouge) et vraies (noir) à l'aide d'un ensemble de données d'apprentissage propre. Dans le deuxième panneau, des données malicieusement mal étiquetées (« poison ») modifient la limite de décision, conduisant à une classification erronée des fausses déclarations comme vraies, ce qui compromet la fiabilité et la sécurité du système.

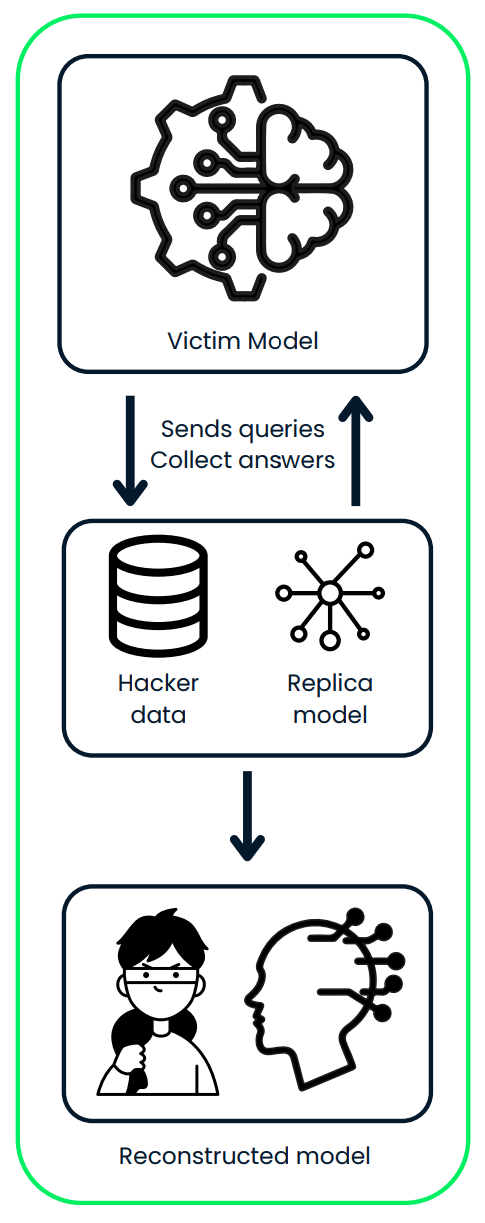

Attaques par extraction de modèle

Dans le cadre d'une attaque par extraction de modèle, un attaquant détermine le fonctionnement d'un modèle d'IA en procédant à une ingénierie inverse. Ils utilisent les entrées et les sorties qu'ils collectent pour reproduire la conception et le comportement du système.

Une fois qu'ils ont construit une réplique du modèle, ils peuvent :

- Veuillez l'utiliser pour établir des prévisions, pouvant impliquer des données sensibles ou privées.

- Veuillez ne pas divulguer d'informations confidentielles provenant du modèle original.

- Modifier et réentraîner le modèle afin de l'adapter à leurs propres besoins, souvent à des fins préjudiciables.

Par exemple, si le modèle volé a été entraîné à partir de données clients privées, l'attaquant pourrait prédire des informations personnelles sur ces clients ou créer une version personnalisée du modèle pour son propre usage.

Examinons quelques exemples concrets :

- Un outil appelé DeepSniffer illustre le fonctionnement de ce type d'attaque. DeepSniffer n'a pas besoin de connaître à l'avance les détails du modèle original. Il recueille plutôt des indices sur la manière dont le modèle traite les données, par exemple en suivant les opérations mémorielles pendant son exécution. Il rassemble ces indices afin de déterminer la structure du modèle, même si le système tente d'optimiser ou de dissimuler ses processus.

- Mindgard a démontré comment les composants essentiels d'un modèle linguistique de type « boîte noire », tel que chatGPT 3.5 Turbo d'OpenAI, peuvent être extraits à l'aide d'un processus peu coûteux. Avec seulement 50 dollars de dépenses API, l'équipe a réussi à créer un modèle plus petit, environ 100 fois plus petit que l'original, qui a surpassé chatGPT dans une tâche spécifique. Ce modèle extrait a ensuite été utilisé pour améliorer une autre attaque, qui a ensuite été déployée contre chatGPT lui-même. L'attaque améliorée a atteint un taux de réussite plus élevé, passant à 11 %.

Ce diagramme illustre une attaque par extraction de modèle, dans laquelle un attaquant interagit avec le modèle d'IA d'une victime en envoyant des requêtes et en collectant ses prédictions. L'attaquant utilise les données recueillies pour entraîner un modèle répliqué, reconstruisant ainsi une version piratée du système original.

Défenses de sécurité IA

Nous avons mentionné dans les sections précédentes qu'à mesure que l'IA se généralise, il est essentiel de mettre en place des mesures de sécurité robustes pour se protéger contre les attaques. Examinons quelques méthodes efficaces pour rendre l'IA plus sécurisée.

Formation contradictoire

Cette méthode consiste à enseigner aux modèles à reconnaître et à traiter des entrées complexes et manipulées (appelées exemples antagonistes). Lorsque vous entraînez votre modèle à l'aide de ces exemples, il devient plus efficace pour résister à certains types d'attaques.

- Fonctionnement : Veuillez créer des exemples de données manipulées et les inclure dans la formation de l'IA.

- Pourquoi cela est utile : Cela rend les systèmes d'IA plus résistants aux attaques visant à les tromper.

- Inconvénient : Cela pourrait légèrement réduire la précision de l'IA sur des données normales (propres).

- Exemples concrets :

- L'API Cloud Vision de Google utilise l'apprentissage antagoniste pour améliorer la résilience de ses modèles de reconnaissance d'images face aux entrées manipulées.

- Les modèles d'OpenAI intègrent des exemples contradictoires dans leur processus d'entraînement afin d'améliorer leur robustesse face aux attaques textuelles.

Distillation défensive

La distillation LLM consiste à entraîner un modèle secondaire à imiter le comportement du modèle original dans le but de rendre plus difficile sa manipulation par des attaquants.

- Fonctionnement : Entraînez le premier modèle, puis utilisez ses résultats pour entraîner un autre modèle de manière à optimiser son processus décisionnel.

- Pourquoi cela est utile : Cela rend plus difficile pour les attaquants d'exploiter les faiblesses.

- Inconvénient : Cette approche peut nécessiter une grande puissance de calcul, en particulier pour les modèles de grande taille.

- Exemples concrets :

- Des chercheurs de l'université de Californie à Berkeley ont appliqué la distillation défensive afin d'améliorer la robustesse des réseaux neuronaux profonds utilisés dans les véhicules autonomes.

- La plateforme d'intelligence artificielle Watson d'IBM utilise des techniques de distillation défensive pour protéger ses modèles de traitement du langage naturel contre les attaques adversaires.

Validation et nettoyage des entrées

Il est essentiel de s'assurer que les données entrant dans un système d'IA sont fiables et sécurisées afin de le protéger contre les entrées malveillantes.

- Fonctionnement : Veuillez vérifier que les entrées sont au format approprié, qu'elles se situent dans les plages attendues et qu'elles ne contiennent pas d'éléments nuisibles.

- Pourquoi cela est utile : Empêche les attaques telles que l'empoisonnement des données et assure le bon fonctionnement du système d'IA.

- Meilleures pratiques : Vérifiez les données à plusieurs étapes : côté utilisateur, côté serveur et au sein même du système d'IA.

- Exemples concrets :

- Les services Azure AI de Microsoft mettent en œuvre une validation stricte des entrées afin de prévenir les attaques par injection SQL sur leurs modèles d'apprentissage automatique.

- Le système de reconnaissance faciale Rekognition d'Amazon utilise la désinfection des entrées pour filtrer les images potentiellement malveillantes.

Méthodes d'ensemble

L'utilisation conjointe de plusieurs modèles d'IA différents (un ensemble) peut renforcer la sécurité des systèmes. Même si un modèle est compromis, les autres peuvent assurer la continuité des opérations.

- Fonctionnement : Combiner les prévisions de plusieurs modèles pour prendre des décisions.

- Pourquoi cela est utile : Il est plus difficile pour les attaquants de compromettre tous les modèles en même temps.

- Inconvénient : Nécessite davantage de ressources informatiques pour gérer plusieurs modèles.

- Exemples concrets :

- Le système de recommandation de Netflix utilise un ensemble de plusieurs modèles d'IA afin d'améliorer la précision et la résilience face aux tentatives de manipulation.

- Les méthodes d'ensemble ne sont pas exclusivement utilisées pour la sécurité dans le domaine de l'IA ; elles sont généralement employées pour créer des modèles prédictifs plus robustes et plus précis.

IA explicable (XAI)

Rendre les systèmes d'IA explicables aide les personnes à comprendre leur fonctionnement et à détecter toute vulnérabilité ou comportement inhabituel. Vous pouvez approfondir ce sujet dans le cours « Expliquez l'IA en Python »..

- Fonctionnement : Veuillez utiliser des outils tels que LIME, SHAP ou des mécanismes d'attention pour expliquer les décisions prises par l'IA.

- Pourquoi cela est utile : Renforce la confiance dans les systèmes d'IA et facilite la détection et la résolution de problèmes tels que les biais.

- Défi : Les modèles plus simples et plus faciles à expliquer peuvent ne pas être aussi performants que les modèles complexes.

- Exemple concret :

- Le programme « Explainable AI » (XAI) de la DARPA vise à développer des systèmes d'IA plus transparents pour des applications militaires.

- La boîte à outils AI Explainability 360 d'IBM fournit des ressources open source pour la mise en œuvre de techniques d'IA explicables dans divers secteurs.

Audits de sécurité réguliers

Vérifier régulièrement les faiblesses des systèmes d'IA peut aider à détecter les problèmes à un stade précoce et à garantir leur sécurité à long terme.

- Ce que cela implique : Effectuer des évaluations de vulnérabilité, des tests de pénétration et des revues de code.

- À quelle fréquence : Effectuez des audits régulièrement et après avoir apporté des modifications importantes au système.

- Pourquoi cela est utile : Identifie les lacunes potentielles en matière de sécurité et garantit la conformité aux réglementations.

- Exemples concrets :

- Facebook procède à des audits de sécurité réguliers de ses systèmes de modération de contenu basés sur l'intelligence artificielle afin d'identifier et de corriger les vulnérabilités potentielles.

- La loi européenne sur l'IA propose des audits de sécurité obligatoires pour les systèmes d'IA à haut risque utilisés dans des secteurs critiques.

L'utilisation de ces stratégies peut rendre les systèmes d'IA plus sécurisés et mieux protégés contre les attaques. Cependant, il est important de noter que la sécurité de l'IA n'est pas une solution que l'on peut « configurer et oublier ». Il s'agit d'un processus continu.

À mesure que de nouvelles menaces apparaissent, et croyez-moi, elles apparaissent toujours, les entreprises doivent rester vigilantes. Cela implique une surveillance constante des vulnérabilités, la mise à jour des systèmes et l'amélioration des défenses.

|

Méthode |

Fonctionnement |

Pourquoi cela est-il utile ? |

Inconvénients |

|

Formation contradictoire |

Veuillez créer des exemples de données manipulées et les inclure dans la formation de l'IA. |

Améliore la robustesse face aux attaques adversaires qui tentent de tromper le système. |

Peut légèrement réduire la précision de l'IA sur des données normales (propres). |

|

Distillation défensive |

Entraînez un modèle secondaire à reproduire le comportement du modèle original, en optimisant son processus décisionnel. |

Rend plus difficile pour les attaquants d'exploiter les faiblesses du modèle. |

Nécessite une grande puissance de calcul, en particulier pour les modèles de grande taille. |

|

Validation et nettoyage des données saisies |

Veuillez vérifier que les données saisies sont au format correct, qu'elles se situent dans les plages attendues et qu'elles ne contiennent pas d'éléments nuisibles. |

Empêche la contamination des données et garantit le bon fonctionnement du système d'IA. |

Nécessite une mise en œuvre minutieuse à plusieurs étapes. |

|

Méthodes d'ensemble |

Combinez les prévisions de plusieurs modèles pour prendre des décisions. |

Il est plus difficile pour les attaquants de compromettre tous les modèles simultanément. |

Nécessite davantage de ressources informatiques pour gérer et maintenir plusieurs modèles. |

|

IA explicable (XAI) |

Veuillez utiliser des outils tels que LIME, SHAP ou des mécanismes d'attention pour expliquer les décisions prises par l'IA. |

Renforce la confiance et facilite l'identification et la résolution de problèmes tels que les préjugés ou les comportements inhabituels. |

Les modèles plus simples et explicables peuvent ne pas être aussi performants que les modèles complexes. |

|

Audits de sécurité réguliers |

Effectuer des évaluations de vulnérabilité, des tests de pénétration et des revues de code afin d'identifier les faiblesses. |

Identifie les lacunes potentielles en matière de sécurité et garantit la conformité aux réglementations. |

Peut nécessiter d'importantes ressources en fonction de la complexité du système. |

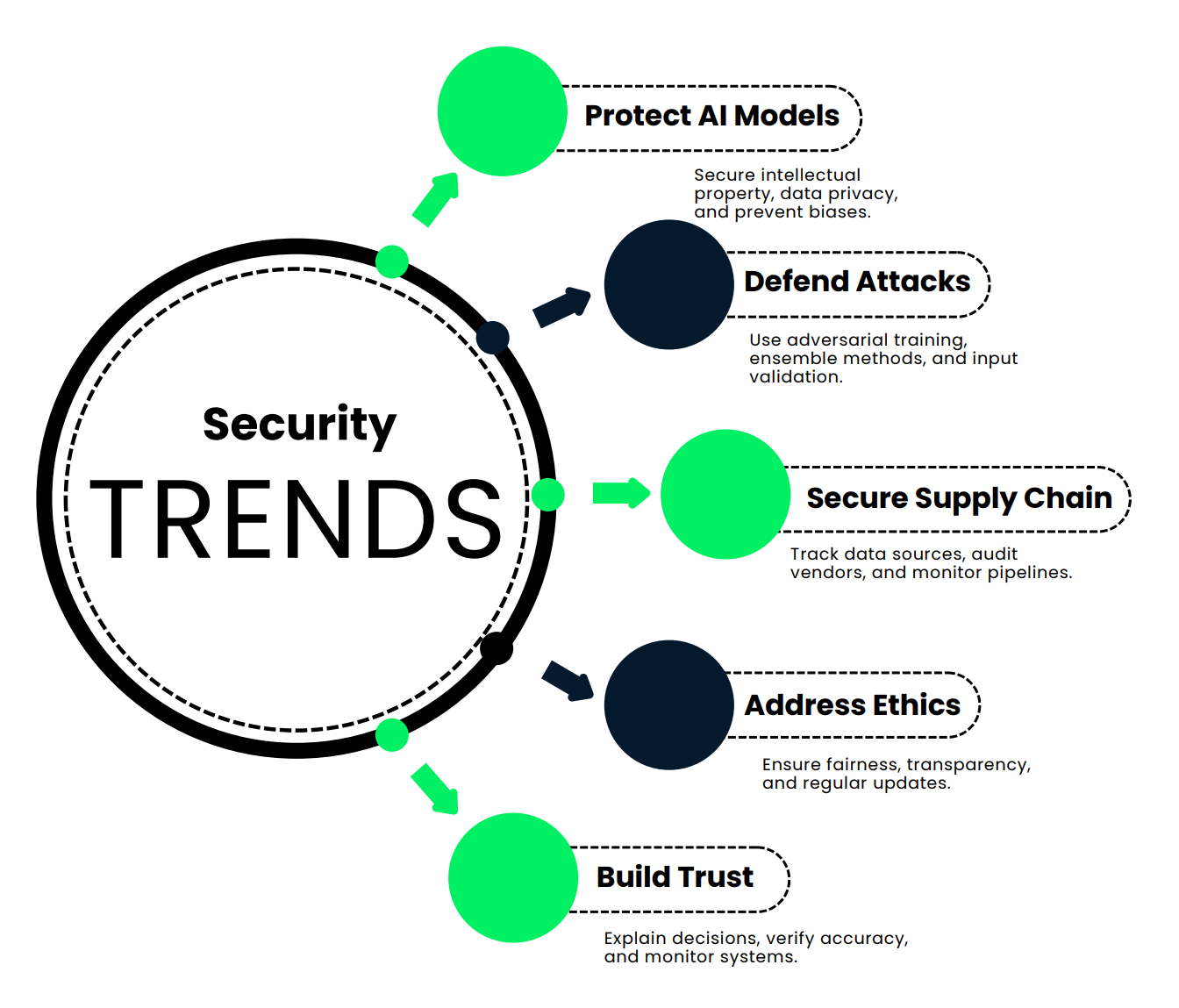

Nouvelles tendances en matière de sécurité de l'IA

Dans cette section, nous examinons les nouvelles tendances qui garantissent la sécurité, la précision et la fiabilité des systèmes d'IA.

Protection des modèles d'IA et de l'intégrité des données

Tout d'abord, discutons de l'importance de la protection des modèles et des données d'IA.

- Protection de la propriété intellectuelle : Veuillez considérer le temps, les ressources financières et l'intelligence nécessaires à la création d'un modèle d'IA. Il ne s'agit pas seulement d'algorithmes, mais également d'investissements considérables. Les protéger empêche les concurrents de s'approprier le fruit de ce travail acharné.

- Maintenir un avantage concurrentiel : Si une personne accède sans autorisation à votre modèle d'IA, elle pourrait le copier et obtenir les mêmes résultats, sans investir dans le développement.

- Confidentialité des données et conformité : L'IA traite souvent des données sensibles : informations financières, dossiers médicaux, etc. Si ces données sont divulguées, vous risquez de lourdes amendes et une perte de confiance considérable de la part du public. Pour en savoir plus, veuillez consulter cette Introduction à la confidentialité des données.

- Prévention de l'altération des données : Les pirates informatiques pourraient manipuler vos données d'entraînement, amenant votre IA à prendre de mauvaises décisions, comme laisser passer des fraudes ou signaler des actions innocentes comme des menaces.

- Atténuer les attaques par inversion de modèle : Imaginez que des attaquants puissent découvrir les informations confidentielles de vos clients simplement en analysant les résultats de votre IA. Ce ne serait pas souhaitable.

- Éviter les résultats biaisés ou contraires à l'éthique : Un modèle compromis peut conduire à des décisions injustes, voire préjudiciables, susceptibles de nuire à votre réputation.

- Protection des infrastructures critiques : Étant donné que l'IA est utilisée dans les domaines de la santé, de la finance et même de la sécurité nationale, sa protection n'est pas seulement une préoccupation commerciale, c'est aussi une question de sécurité publique.

Alors, comment pouvez-vous réellement assurer la sécurité de votre IA ? Voici quelques stratégies clés :

- Utiliser le le cryptage et l'anonymisation des données pour protéger les informations sensibles.

- Mettre en œuvre des politiques rigoureuses de conservation des données des politiques strictes de conservation des données afin de contrôler la durée de stockage des informations.

- Effectuer des des audits de sécurité et une surveillance réguliers afin de détecter rapidement les vulnérabilités.

- Concevoir des systèmes respectueux de la principes de protection de la vie privée dès la conception , en intégrant la sécurité à chaque étape.

- Utilisez des techniques avancées telles que l' l'apprentissage fédéré pour protéger le modèle et ses données sans déplacer d'informations sensibles.

Illustrons cela à l'aide d'un scénario concret. Veuillez imaginer une grande banque internationale qui a développé un modèle d'intelligence artificielle pour détecter les transactions frauduleuses. Ce système traite quotidiennement des millions de transactions, détecte les schémas suspects et signale les fraudes.

La banque a investi 50 millions de dollars et trois années pour développer ce système. En cas de vol, les concurrents pourraient l'utiliser sans investir le moindre centime, ce qui ferait perdre à la banque son avantage concurrentiel.

Ce modèle traite les données financières sensibles de millions de clients. Une violation pourrait exposer ces informations, entraînant des amendes importantes en vertu de lois telles que le RGPD.

Si des pirates informatiques introduisaient de fausses données pendant la phase d'apprentissage, ils pourraient entraîner l'IA à ignorer certains schémas de fraude, rendant ainsi la banque vulnérable.

Des attaquants expérimentés pourraient même extraire des informations confidentielles sur les clients à partir des résultats du modèle.

Comment la banque assure-t-elle sa protection ?

- Ils utilisent un un cryptage de bout en bout pour sécuriser les données.

- L'accès au modèle nécessite une une authentification multifactorielle et est limité par des des contrôles basés sur les rôles.

- Ils effectuent régulièrement des audits et des tests de pénétration afin de détecter les faiblesses.

- Les données clients utilisées pour la formation sont entièrement anonymisées.

- La banque surveille constamment les performances du modèle afin de détecter toute anomalie.

Il en résulte un système d'IA plus sûr et plus fiable, qui protège les données des clients et tient sa promesse de détecter efficacement les fraudes. C'est une situation avantageuse tant pour la banque que pour ses clients.

Se prémunir contre les attaques par évasion et empoisonnement

Imaginez que vous soyez responsable d'un établissement hautement sécurisé qui utilise la reconnaissance faciale pour garantir la sécurité. Cependant, nous avons constaté que les systèmes d'IA sont vulnérables aux attaques, telles que les entrées adversaires ou les données d'entraînement corrompues. Les pirates informatiques peuvent manipuler le système pour y accéder.

Examinons les quatre défenses clés qui peuvent empêcher les attaquants de poursuivre leur cursus :

- Formation antagoniste : Cela revient à enseigner à votre modèle des techniques d'autodéfense. Vous incluez des exemples d'entrées manipulées, c'est-à-dire des images légèrement modifiées dans le but de tromper l'IA, et vous l'entraînez à les reconnaître. Imaginez un système de reconnaissance faciale qui détecte non seulement votre visage, mais également les modifications pixel par pixel que les attaquants tentent d'introduire. Votre IA devient plus performante face à ces attaques, en tirant des enseignements de ces exemples afin de ne pas être trompée dans la réalité.

- Méthodes d'ensemble : Nous en avons déjà discuté précédemment. Au lieu de vous appuyer sur un seul système, vous utilisez une équipe de modèles. Chaque modèle traite les données d'entrée de manière indépendante, et leurs résultats sont combinés à l'aide d'un mécanisme de vote. Les attaquants ne peuvent pas se contenter de tromper un seul modèle, ils doivent tromper toute l'équipe. Je vous souhaite bonne chance.

- Vérifications régulières des données : Personne n'apprécie particulièrement le nettoyage, mais il s'agit d'une opération d'entretien essentielle pour votre IA. Des audits hebdomadaires garantissent que vos données de formation ne contiennent pas de doublons, d'entrées mal étiquetées ou d'entrées malveillantes. De plus, maintenir la fraîcheur de l'ensemble de données grâce à des images vérifiées contribue à préserver la performance de votre système..

- de validation des données d'entrée Avant qu'une image n'atteigne votre IA, elle est soumise à un contrôle de sécurité. Voici ce qui se produit :

- Le format et la taille sont vérifiés.

- Les métadonnées sont analysées afin de détecter tout signe d'altération.

- Les modèles adversaires connus sont signalés.

- La détection des anomalies permet de repérer tout élément inhabituel.

Le système n'est pas seulement intelligent, il est également prudent. Chaque entrée doit prouver sa légitimité avant de pouvoir être traitée.

Sécurisation des chaînes d'approvisionnement en IA

Sécuriser l'IA consiste à gérer l'intégrité des données, à protéger les modèles propriétaires et à s'assurer que tout fonctionne correctement avec votre configuration de cybersécurité existante. Il convient également de prendre en compte la nécessité de faire face à l'évolution des menaces, à la conformité réglementaire, à l'éthique et aux vulnérabilités de la chaîne d'approvisionnement. Voici quelques stratégies pour sécuriser le cycle de vie de l'IA :

- Veuillez suivre vos sources : Chaque donnée et chaque modèle de votre système d'IA doivent avoir une origine claire. Veuillez documenter la provenance du document, qu'il s'agisse d'un hôpital de renom, d'un institut de recherche ou d'un fournisseur spécialisé. Pourquoi ? Car connaître la source est la première étape pour savoir si l'on peut lui faire confiance.

- Vérifiez vos fournisseurs : Les fournisseurs tiers sont essentiels, mais ils peuvent également constituer des points faibles potentiels. Effectuez régulièrement des audits afin de vous assurer qu'ils respectent vos normes de sécurité, qu'il s'agisse de la conformité HIPAA, des protocoles d'anonymisation des données ou des certifications ISO.

- Veuillez utiliser des outils de suivi des données : Vos données ne sont pas statiques. Au fil du temps, il évolue, et cette évolution peut parfois inclure des erreurs ou des modifications malveillantes. Des outils tels que la surveillance automatisée des données permettent de suivre les modifications et de signaler les changements inattendus, garantissant ainsi la propreté et l'exactitude de vos ensembles de données.

- Surveiller les pipelines de données : Les données transitent de la source vers le modèle via des pipelines complexes, et tout incident en cours de route peut entraîner des complications. Les tableaux de bord en temps réel peuvent vous aider à détecter les anomalies, telles que les baisses soudaines du volume de données ou les modifications inattendues des fonctionnalités.

Voici un exemple concret. Prenons l'exemple d'une entreprise du secteur de la santé qui développe un outil de diagnostic basé sur l'intelligence artificielle. Leur chaîne d'approvisionnement comprend :

- Données des patients provenant des hôpitaux partenaires.

- Ensembles de données d'imagerie médicale provenant d'un institut de recherche de premier plan.

- Modèles pré-entraînés provenant d'un fournisseur spécialisé en intelligence artificielle.

Comment assurent-ils la sécurité de ce pipeline ?

- Sources de cursus: Chaque ensemble de données et chaque modèle sont soigneusement documentés afin d'assurer leur traçabilité.

- Audits des fournisseurs: Ils procèdent à des vérifications trimestrielles de conformité à la loi HIPAA et garantissent l'anonymisation des données. Les fournisseurs sont soumis à des évaluations de sécurité annuelles afin de conserver leurs certifications.

- Outils de traçabilité des données: Ils utilisent des outils tels qu'Anomalo pour détecter les changements inattendus dans les données démographiques des patients ou les données d'imagerie.

- s de surveillance des pipelines: Les tableaux de bord en temps réel de Looker surveillent le flux de données et signalent immédiatement toute anomalie.

De cette manière, ils disposent d'une chaîne logistique sécurisée en matière d'IA qui garantit la précision, la fiabilité et la conformité de leur outil de diagnostic aux normes de l'industrie.

Gérer les risques éthiques

L'intelligence artificielle est puissante, mais cette puissance peut être préoccupante entre de mauvaises mains. Si un système d'IA est piraté ou mal conçu, cela peut entraîner des décisions biaisées, des résultats contraires à l'éthique, voire une utilisation abusive. C'est un sujet important, en particulier lorsque l'IA prend des décisions qui ont un impact sur la vie réelle, comme l'embauche, les prêts ou les soins de santé.

Comment pouvons-nous rendre les systèmes d'IA plus éthiques et résilients ? Décomposons cela en quatre étapes clés :

- Élaborez des règles et des cadres clairs : Commencez par établir des bases solides. Cela implique l'élaboration de politiques qui définissent ce que sont l'équité et l'éthique pour votre système.

- Former les équipes d'IA à l'éthique : Il n'est pas raisonnable d'attendre de l'IA qu'elle agisse de manière éthique si les personnes qui la développent ne sont pas en mesure de réfléchir de manière critique à ces questions. La formation à l'éthique aide les équipes à reconnaître et à traiter les préjugés inconscients, à comprendre la notion d'équité et à appréhender l'impact social de leur travail.

- Rendre les décisions prises par l'IA transparentes : La transparence implique de concevoir des systèmes capables d'expliquer leurs décisions : quels facteurs ont été pris en compte, comment les candidats ont été comparés et où pourraient se situer les éventuelles préoccupations. La transparence favorise la confiance et la responsabilité.

- Veuillez mettre à jour régulièrement les systèmes d'IA : L'IA n'est pas une technologie que l'on peut configurer une fois pour toutes. Des audits réguliers permettent d'identifier et de réduire les biais, de garantir l'équité et de maintenir la conformité du système avec les dernières normes industrielles et exigences légales. L'équité n'est pas statique ; c'est un processus continu.

Voici un exemple concret. Examinons le cas d'une grande entreprise technologique qui utilise un système de recrutement basé sur l'intelligence artificielle. Comment garantissent-ils le respect des normes éthiques ?

- Élaborez des règles claires : Ils élaborent une politique éthique en matière d'IA qui définit les principes d'un recrutement impartial, couvrant tous les aspects, de la collecte de données à la prise de décision. Un comité d'éthique de l'IA supervise ces politiques afin de garantir la responsabilité.

- Former les équipes : La formation à l'éthique devient obligatoire pour tous les employés travaillant sur le système. Ils suivent des cours sur les préjugés inconscients et l'équité dans l'apprentissage automatique et participent à des ateliers abordant des dilemmes concrets.

- Transparence : Le système de recrutement comprend des outils d'explicabilité. Pour chaque recommandation, il fournit une analyse détaillée des facteurs influençant la décision, tels que les qualifications clés ou la comparaison d'un candidat par rapport aux autres. Cela facilite la révision des décisions par les responsables des ressources humaines.

- Mises à jour régulières : Des audits trimestriels évaluent les décisions d'embauche afin de détecter tout biais et appliquent des techniques telles que la correction des biais contradictoires afin d'améliorer continuellement l'équité. Ils actualisent également le système en fonction des dernières lois sur l'égalité dans l'emploi et des meilleures pratiques du secteur.

Il s'agit d'un système de recrutement éthique, équitable et transparent, même face à d'éventuels compromis.

Défis en matière d'explicabilité et de confiance

Les systèmes d'IA sont souvent considérés comme des « boîtes noires », ce qui signifie que leur processus décisionnel n'est pas facile à appréhender. Cela peut compliquer l'identification des problèmes ou l'établissement d'une relation de confiance. Si vous êtes un médecin qui utilise un outil d'IA ou un patient concerné par sa décision, vous souhaitez des réponses, pas des interrogations. La solution réside dans l'explicabilité. Voici quatre stratégies pour rendre les systèmes d'IA plus transparents et plus fiables :

- Utilisez des outils d'IA explicable (XAI) : Ces outils contribuent à clarifier la manière dont l'IA parvient à ses conclusions. Par exemple, des techniques telles que LIME ou SHAP peuvent indiquer quels facteurs ont influencé une décision spécifique, ce qui rend le raisonnement du système plus accessible.

- Suivre et documenter les modifications apportées aux données : Lorsque vous consignez chaque modification, telle que les données ajoutées, supprimées ou modifiées, vous pouvez suivre l'impact de ces mises à jour sur les performances du modèle.

- Vérifiez régulièrement l'exactitude : Il est important de ne pas considérer l'IA comme une solution miracle. Veuillez comparer ses résultats aux données originales et, si possible, solliciter l'avis d'experts humains. Des audits réguliers garantissent que le système reste performant et impartial. Faites confiance, mais vérifiez.

- Veuillez tester et surveiller en permanence : L'IA n'est pas un outil que l'on peut configurer une fois pour toutes. Des tests fréquents avec des entrées variées permettent de détecter les erreurs à un stade précoce, et la surveillance en temps réel garantit que le système fonctionne de manière cohérente dans différents scénarios.

Examinons comment un hôpital établit la confiance dans un outil de diagnostic dermatologique basé sur l'IA, un système qui utilise la reconnaissance d'images pour identifier d'éventuelles affections cutanées.

- Outils XAI : L'hôpital utilise LIME, un outil qui met en évidence les parties d'une image cutanée qui ont le plus influencé le diagnostic de l'IA, afin que les médecins puissent comprendre et avoir confiance dans le raisonnement de l'IA.

- Suivi des modifications apportées aux données : Une outil de traçabilité des données enregistre toutes les mises à jour apportées à l'ensemble de données d'entraînement, telles que les images nouvellement ajoutées ou supprimées. Cela permet à l'hôpital de suivre l'impact de ces changements sur la précision de l'IA au fil du temps.

- Vérification de l'exactitude : Chaque mois, des dermatologues examinent un échantillon aléatoire de diagnostics établis par l'IA, en les comparant aux données originales des patients et à leur propre avis d'expert. L'objectif ici est de garantir que le système maintienne des normes élevées en matière de précision et d'équité.

- Tests et surveillance réguliers : L'équipe informatique effectue des tests hebdomadaires avec diverses images, vérifiant les performances de l'IA sur différents types et conditions de peau. Ils surveillent également les schémas inhabituels en temps réel, ce qui leur permet de résoudre les problèmes avant qu'ils ne s'aggravent.

Cet outil d'intelligence artificielle est non seulement intelligent, mais également explicable et fiable. Les médecins comprennent ses décisions, les patients ont confiance dans les soins prodigués et l'hôpital veille à ce que la technologie fonctionne de manière équitable et précise.

Conclusion

À mesure que l'IA occupe une place de plus en plus importante dans nos vies, il est plus crucial que jamais d'en assurer la sécurité. Pourquoi ? En effet, la même puissance qui stimule les capacités de l'IA en fait également une cible pour les attaques. Les menaces telles que les attaques adversaires, l'empoisonnement des données et le vol de modèles peuvent sérieusement perturber le fonctionnement de l'IA.

Comment pouvons-nous donc défendre l'IA ? Nous avons appris qu'il n'existe pas de solution universelle. Des techniques telles que la formation antagoniste, les audits réguliers et les mesures de protection multicouches peuvent réduire les risques et renforcer la robustesse de vos systèmes.

Il y a également l'IA générative. Les grands modèles linguistiques offrent des opportunités exceptionnelles, mais ils introduisent également de nouvelles vulnérabilités. De la production de contenus trompeurs à la manipulation visant à générer des résultats préjudiciables, ces outils nécessitent une surveillance attentive. Dans l'article intitulé « « Comment mettre en place des garde-fous pour les grands modèles linguistiques », il est question des mesures de sécurité permettant de garantir que les LLM se comportent comme prévu.

L'éthique et la transparence sont des principes non négociables. Les systèmes d'IA doivent être équitables, explicables et dignes de confiance. Les préjugés et les abus peuvent éroder la confiance, et la confiance est essentielle dans le monde actuel axé sur la technologie. Les gens n'utiliseront pas ce en quoi ils n'ont pas confiance.

Enfin, il est essentiel de rester à l'avant-garde. Les menaces liées à l'intelligence artificielle évoluent constamment. Les entreprises doivent régulièrement mettre à jour leurs stratégies de sécurité afin de s'adapter aux nouveaux risques et de rester protégées.La clé réside dans une approche proactive, vigilante et engagée en faveur de l'éthique et de la transparence. De cette manière, les entreprises peuvent instaurer la confiance et tirer le meilleur parti des avantages de l'IA.

Ana Rojo Echeburúa est une spécialiste de l'IA et des données, titulaire d'un doctorat en mathématiques appliquées. Elle aime transformer les données en informations exploitables et possède une grande expérience de la direction d'équipes techniques. Ana aime travailler en étroite collaboration avec ses clients pour résoudre leurs problèmes commerciaux et créer des solutions d'IA innovantes. Connue pour ses compétences en matière de résolution de problèmes et de communication claire, elle est passionnée par l'IA, en particulier l'IA générative. Ana se consacre à l'apprentissage continu et au développement éthique de l'IA, ainsi qu'à la simplification des problèmes complexes et à l'explication de la technologie de manière accessible.