programa

La gente decía que 2025 iba a ser el año de los agentes de IA, pero a solo tres meses de que termine, me parece que se está convirtiendo en el año de los medios generados por IA, con lanzamientos muy populares como Veo 3, Nano Banana y ahora, Sora 2.

Quería hacer una reseña completa de Sora 2, igual que hice con Veo 3, pero aún no tengo acceso, a pesar de que tengo la suscripción a chatGPT Pro. Actualmente, el despliegue del acceso es muy lento, y se hace hincapié en entrar mediante un código de invitación de la nueva aplicación de redes sociales Sora (más información al respecto en breve).

Probablemente el objetivo sea atraer a más usuarios, pero personalmente creo que es una mala decisión desde el principio, ya que supongo que hay más gente interesada en crear vídeos con Sora que en utilizar la aplicación de redes sociales.

OpenAI tiene mucho terreno que recorrer para ponerse al nivel de la combinación de Veo 3 y Nano Banana de Google, y creo que han empezado con mal pie al condicionar el acceso a tener un iPhone en Estados Unidos o Canadá, incluso para las personas que ya pagan 200 dólares por una suscripción a chatGPT Pro.

Dicho esto, voy a hacer un repaso completo de lo que sabemos hasta ahora sobre Sora 2 (tanto el modelo como la nueva aplicación de redes sociales) y, dado que Meta también ha lanzado Vibes , que básicamente es un feed de vídeos de IA, también comentaré por qué creo que las empresas de IA están apostando de repente por las aplicaciones de medios y entretenimiento.

Mantenemos a nuestros lectores al día sobre las últimas novedades en IA mediante el envío de The Median, nuestro boletín informativo gratuito de los viernes que resume las noticias más importantes de la semana. Suscríbete y mantente al día en solo unos minutos a la semana:

¿Qué es Sora 2?

Sora 2 no es solo un nuevo modelo de vídeo, sino también el nombre de la última aplicación social de OpenAI. Así que cuando la gente habla de Sora ahora mismo, puede referirse a dos cosas distintas:

- Sora 2, el modelo, que genera vídeo y audio a partir de indicaciones de texto (similar a Veo 3), y

- Sora, la aplicación social, una nueva plataforma iOS solo por invitación que te permite remezclar vídeos utilizando las imágenes de otras personas, descubrir contenido en un feed y compartir clips generados por IA en las redes sociales.

Ambos están estrechamente relacionados, ya que la aplicación se ejecuta en el modelo Sora 2, pero tienen objetivos diferentes. El modelo es el intento de OpenAI de crear un sistema de generación de vídeo y audio de uso general. La aplicación es un experimento sobre lo que ocurre cuando se envuelve esa capacidad en una capa social breve y remezclable.

Analizaremos ambos en detalle en las siguientes secciones. Pero empecemos por la atracción principal: Sora 2, el modelo de vídeo.

Sora 2: El modelo de vídeo

Lo primero que me llamó la atención de Sora 2 es que el equipo de OpenAI finalmente ha logrado resolver la salida de audio nativa, que hasta ahora era uno de los principales atractivos de Veo 3. Sora 2 puede generar diálogos, ambientes de fondo y efectos de sonido directamente junto con las imágenes, sin tener que añadir nada posteriormente.

Además, el modelo promete otras mejoras. Repasemos cada una de las mejoras anunciadas y analicemos críticamente algunos ejemplos.

Más preciso físicamente

Se supone que Sora 2 comprende mejor conceptos como el peso, el equilibrio, la permanencia de los objetos y la relación causa-efecto. Si alguien falla un tiro en baloncesto, la pelota debe rebotar en el aro, en lugar de teletransportarse mágicamente al interior de la canasta, como hemos visto en modelos anteriores. Analicemos este ejemplo:

La dinámica física parece bastante convincente durante la mayor parte del vídeo, pero si te fijas en los últimos fotogramas (los últimos 0,5 segundos), verás que las piernas del patinador se estiran hasta alcanzar una forma imposible y casi deformada.

Cuando el gato se cae de la cabeza del patinador, la caída parece ingrávida y antinatural. Luego, al final, el gato hace una pirueta imposible.

Otro problema importante de este vídeo es que hay continuidad en el audio, pero no en el vídeo. Al escuchar al locutor hablando por el micrófono en el estadio, podemos deducir que la acción y el tiempo son continuos porque no hay cortes en el sonido, pero el vídeo de 10 segundos está compuesto en realidad por tres tomas diferentes que claramente tuvieron lugar en momentos distintos. Tengo claro que Sora 2 no tiene ni idea de los principios básicos del montaje.

Capaz de simular fallos

Otra mejora sutil (pero muy útil) es que Sora 2 ahora puede generar errores realistas. Los modelos anteriores representaban principalmente acciones exitosas: alguien siempre aterriza el salto, siempre marca el gol. Sora 2 intenta simular el fallo, lo cual es más difícil de lo que parece. Para la IA, «meter la pata» de forma realista a menudo requiere un modelo interno más profundo de la física y el comportamiento humano.

Veamos un ejemplo:

De hecho, me gusta bastante este vídeo, casi me convence de que la caída es real. Lo único que rompe la ilusión es el equilibrio imposible hacia el final. Es discutible, pero creo que el hombre debería haber caído mucho antes.

Dicho esto, la capacidad de generar errores tiene un gran potencial. El caso de uso más obvio que se me ocurre es cuando necesitas filmar una toma peligrosa. En lugar de recurrir a una persona real, tal vez podrías probar con la inteligencia artificial para evitar complicaciones y reducir también el presupuesto.

Mejor continuidad

OpenAI afirma que Sora 2 puede obedecer instrucciones complejas en múltiples tomas manteniendo el mismo personaje, la misma iluminación y el mismo estado general del mundo. Por lo tanto, si pides que un hombre con una chaqueta roja entre en un edificio, camine por un pasillo y coja un periódico de un escritorio, la chaqueta debe seguir siendo roja, el pasillo debe permanecer igual y no deben aparecer de repente dos periódicos o tres brazos.

Este es el ejemplo más relevante que he encontrado para esta función:

Este ejemplo reúne seis impresionantes tomas en un solo vídeo de 10 segundos. Lo que realmente transmite la continuidad es el sonido: las conversaciones de fondo, los fuegos artificiales y los diálogos están generados de forma impresionante. No puedo juzgar la semántica porque no entiendo el idioma que se habla, pero acústicamente funciona.

Sin embargo, una vez que observas más detenidamente las imágenes, las cosas empiezan a volverse confusas. La distancia entre los personajes cambia demasiado: a veces están muy separados y, de repente, segundos después, se tocan las manos. La cámara también salta el eje de una manera que parece aleatoria, lo que hace que sea realmente difícil entender la geografía del espacio y la posición de los personajes.

Dicho esto, la consistencia del rostro es perfecta, así que le daré crédito al modelo por eso. La iluminación también es uniforme, y la gradación de color en blanco y negro se mantiene en todas las tomas.

Estilo flexible

OpenAI afirma que el modelo puede cambiar con fluidez entre estilos realistas, cinematográficos y animados, incluido el anime, al tiempo que conserva el movimiento y la identidad. Esto resulta útil para los creadores que desean obtener resultados estilizados sin perder por completo el control de la escena.

Tengo que decir que este es quizás el ejemplo que más me gusta de todo lo que han mostrado. Hay cosas que funcionan y cosas que no, pero en cuanto a la historia, en mi opinión, es una escena muy bien construida, sobre todo porque tiene una dinámica emocional funcional.

El mundo que rodea a los protagonistas es feliz: la gente disfruta de una especie de festival nocturno, los fuegos artificiales iluminan el cielo y se respira un ambiente festivo. Pero en medio de todo eso, los dos personajes principales parecen estar teniendo una conversación muy difícil, da la sensación de que están a punto de romper de forma irreversible.

No entiendo el idioma, así que no puedo decir con certeza qué están diciendo, pero el tono emocional se percibe claramente. La música está muy bien elegida, ligeramente alegre, en consonancia con el escenario, y el primer plano al final, con los fuegos artificiales reflejados en los ojos del personaje femenino, es lo que realmente transmite el mensaje.

Si tuviera que quejarme de algo, sería de que las personas que te rodean no se mueven en absoluto. Pero esto también podría ser una elección intencionada: estamos viendo una visión subjetiva de la escena, en la que el mundo que les rodea se ha detenido por un momento porque están tan absortos en su propio mundo tenso que, subjetivamente, el mundo exterior ha dejado de existir para ustedes.

Sora: La aplicación social

Junto con el modelo, OpenAI también lanzó una nueva aplicación para iOS llamada Sora, que añade una capa social completa a la experiencia de generación de vídeos. En este momento, la aplicación es la principal forma de acceder a Sora 2 y, hasta ahora, solo se puede acceder mediante invitación y está limitada a usuarios de Estados Unidos y Canadá.

Supongo que OpenAI quiere ver qué pasa cuando la gente empieza a remezclar el contenido de los demás, insertándose en las escenas y tratando los vídeos de IA más como un lenguaje social. Si esto se convertirá en el próximo TikTok es otra cuestión (creo que las posibilidades son nulas), pero la mecánica es interesante.

¿Cómo funciona la aplicación social Sora?

En esencia, la aplicación Sora es una plataforma basada en feeds creada para vídeos de IA remezclables. Podéis desplazarte por clips cortos generados por otros usuarios, muchos de los cuales incluyen imágenes de personas reales a través de un sistema llamado« » (másinformación al respecto a continuación). Si deseas crear uno propio, puedes escribir un nuevo guion desde cero o remezclar un vídeo existente utilizando el cameo de otra persona, siempre que cuentes con su permiso.

Puedes dar «Me gusta», remezclar, volver a publicar o seguir a usuarios como lo harías en cualquier otra plataforma social. El feed en sí está personalizado, pero OpenAI afirma que no está optimizado para el tiempo de visualización. En cambio, afirman que está configurado para maximizar la creación y la inspiración, y han añadido controles de bienestar, como límites diarios de generación para adolescentes y anulaciones parentales a través de chatGPT.

La aplicación también incluye un sistema de recomendaciones controlado por lenguaje natural, lo que significa que puedes dirigir el tipo de contenido que ves en inglés sencillo (por ejemplo, «muéstrame vídeos divertidos con animales» o «menos cosas surrealistas»).

Funciones destacadas

Probablemente esta sea la característica más novedosa de la aplicación. Los cameos te permiten grabar un breve clip de vídeo y audio de ti mismo, que luego el modelo utiliza para generar una réplica completa de tu persona: voz, apariencia, expresiones y todo lo demás. Una vez que tu cameo haya sido verificado y subido, podrás insertarte en cualquier escena o permitir que tus amigos te incluyan en las suyas.

El planteamiento de OpenAI en este caso es que tú mantienes el control sobre tu imagen en todo momento:

- Tú decides quién puede utilizar tu cameo.

- Puedes revocar el acceso o eliminar cualquier vídeo en el que aparezcas.

- Puedes ver todos los vídeos (incluidos los borradores) en los que apareces.

Es un sistema inteligente, pero también plantea muchas preguntas sobre el consentimiento, los derechos de autor, la moderación y cómo se adapta a diferentes escalas. OpenAI afirma que está creando equipos de revisión humanos para detectar casos extremos, como el acoso, y que se han establecido permisos más estrictos para los usuarios más jóvenes.

¿Por qué este repentino interés por los medios generados por IA?

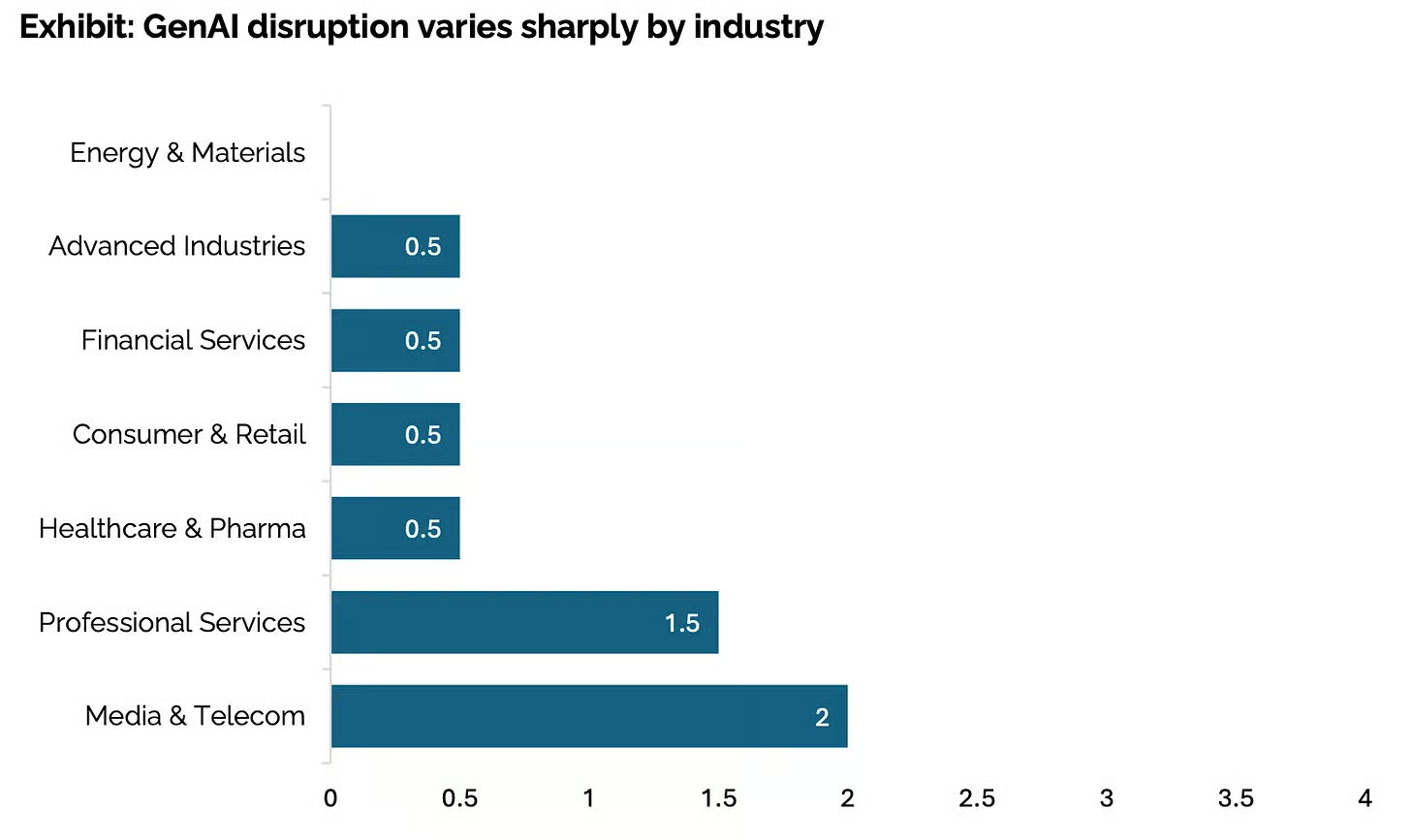

Tal y como señalaba un informe reciente de Stanford, la IA aún no ha revolucionado tantos sectores, con una clara excepción: los medios de comunicación.

Fuente: Informe sobre el estado de la IA en los negocios en 2025

No creo que sea solo una anomalía estadística. He hablado directamente con productores publicitarios y se están tomando este cambio muy en serio. Muchos están experimentando activamente con la IA para reducir los costes de producción, acelerar los plazos y evitar los quebraderos de cabeza logísticos que conlleva el rodaje en un plató.

Se puede observar la misma tendencia en el ámbito público. Si navegas por LinkedIn cualquier día, encontrarás creadores que publican cortometrajes, anuncios y tráilers conceptuales generados por IA. Un buen ejemplo es este anuncio de Kalshi, un anuncio real de una empresa real, producido íntegramente con IA:

Por eso creo que empresas como OpenAI, Google y Meta están apostando de repente por los medios generados por IA. Si hay un ámbito en el que la IA generativa ya está demostrando su utilidad, y en el que la gente está invirtiendo activamente tiempo y dinero, es este. Por lo tanto, es lógico que los laboratorios estén compitiendo por crear plataformas, ecosistemas y capas sociales en torno al vídeo.

La semana pasada, Meta lanzó Vibes, un nuevo feed de vídeos cortos generados por IA, que parece ir tras el mismo espacio que la aplicación Sora de OpenAI. El patrón es bastante claro: sacar provecho de los medios de comunicación y el entretenimiento ahora, mientras que la tecnología aún no es lo suficientemente buena como para alterar de manera fiable otras industrias más reguladas, como la sanidad o las finanzas.

En resumen, el vídeo es el fruto más fácil de alcanzar, y todo el mundo intenta hacerse con él antes que los demás.

Conclusión

Aunque quiero mantener una postura crítica, vale la pena reconocer lo mucho que han avanzado estos modelos de IA. Recuerda que a principios de 2023, lo mejor que podíamos conseguir era ver a Will Smith comiendo espaguetis .. Ahora hablamos de audio nativo, continuidad emocional y aplicaciones sociales de remezcla en toda regla en las que puedes sumergirte en un combate con espadas en un barco pirata o en un surrealista programa de cocina presentado por tu perro.

Dicho esto, Sora 2 sigue teniendo problemas con la coherencia espacial, la lógica básica de edición y el realismo físico sutil. Y la decisión de OpenAI de restringir el acceso a una aplicación para iOS solo por invitación no ayuda precisamente a su reputación entre los usuarios profesionales que buscan herramientas serias. Aquí hay potencial, pero también hay fricciones.

Aún así, está claro que los medios generados por IA son el ámbito al que hay que prestar atención.

Preguntas frecuentes

¿Cómo puedes acceder a Sora 2 si tienes una suscripción a chatGPT Plus o Pro?

Muchos usuarios de X y Reddit con suscripciones existentes a OpenAI están frustrados por el lanzamiento por fases, que da prioridad a los usuarios habituales de Sora 1 antes de ampliarse a los niveles Plus y Pro. Si tienes la versión Pro, comprueba si hay una notificación push en la aplicación chatGPT o visita sora.com para iniciar sesión. El acceso debería desbloquear pronto generaciones ilimitadas de 720p/10 s, y la versión Pro desbloqueará el modo «Sora 2 Pro» de 1080p/20 s. Los usuarios Plus obtienen ventajas similares, pero con posibles colas; el nivel gratuito ofrece pruebas generosas, pero limitadas. Si aún no has recibido ninguna invitación, es debido a la gran demanda. Se esperan oleadas durante la próxima semana, comenzando por Estados Unidos y Canadá antes de su lanzamiento mundial.

¿Cuáles son los límites de generación y los precios de Sora 2?

Los límites de velocidad son un tema candente, y X usuarios califican los «generosos límites» de OpenAI de vagos; los usuarios gratuitos se enfrentan a tiempos de espera (por ejemplo, uno cada 15 minutos), mientras que Plus ofrece generaciones estándar ilimitadas y Pro añade resultados más rápidos y de mayor resolución sin límites. En los hilos de Reddit se especula que los costes de computación hacen que los vídeos más largos (más de 20 segundos) sean solo premium, pero aún no hay muros de pago: es gratuito en el momento del lanzamiento, con actualizaciones de pago para extras como renderizados masivos. Supervisa tu panel de control para conocer las cuotas en tiempo real, ya que se ajustan en función del uso.

¿Sora 2 está disponible fuera de Estados Unidos y Canadá?

La aplicación para iOS y el acceso completo se lanzaron primero en EE. UU. y Canadá el 30 de septiembre de 2025, pero OpenAI tiene previsto expandirse rápidamente a nivel mundial. Los usuarios de la UE ya informan de que tienen acceso a la versión beta a través de chatGPT Pro, aunque con posibles soluciones alternativas de VPN para descargar la aplicación. Consulta el centro de ayuda de OpenAI para conocer el estado de tu país; los retrasos se deben a las leyes de privacidad de datos, pero la mayoría de las regiones deberían tenerlo disponible en unas semanas.

¿Cómo se compara Sora 2 con competidores como Veo 3 o Runway?

X hilos lo comparan con Veo 3 de Google (más potente en cuanto a longitud bruta) y Runway (mejores herramientas de edición), pero Sora 2 gana en precisión física, coherencia de los personajes y audio integrado: los usuarios dicen que parece un «simulador del mundo» para historias coherentes. Los análisis de Reddit señalan que Veo destaca en 4K, pero la capacidad de control de Sora (disparos múltiples, estilos) y su aplicación social lo hacen más divertido y fácil de usar. ¿Inconvenientes? Renderizados más lentos y límite de 720p por ahora. En general, es lo último en realismo, pero la competencia es reñida: prueba las demos para juzgar por ti mismo.

Soy editora y redactora de blogs, tutoriales y noticias sobre IA, y me aseguro de que todo se ajuste a una sólida estrategia de contenidos y a las mejores prácticas de SEO. He escrito cursos de ciencia de datos sobre Python, estadística, probabilidad y visualización de datos. También he publicado una novela premiada y dedico mi tiempo libre a escribir guiones y dirigir películas.