Curso

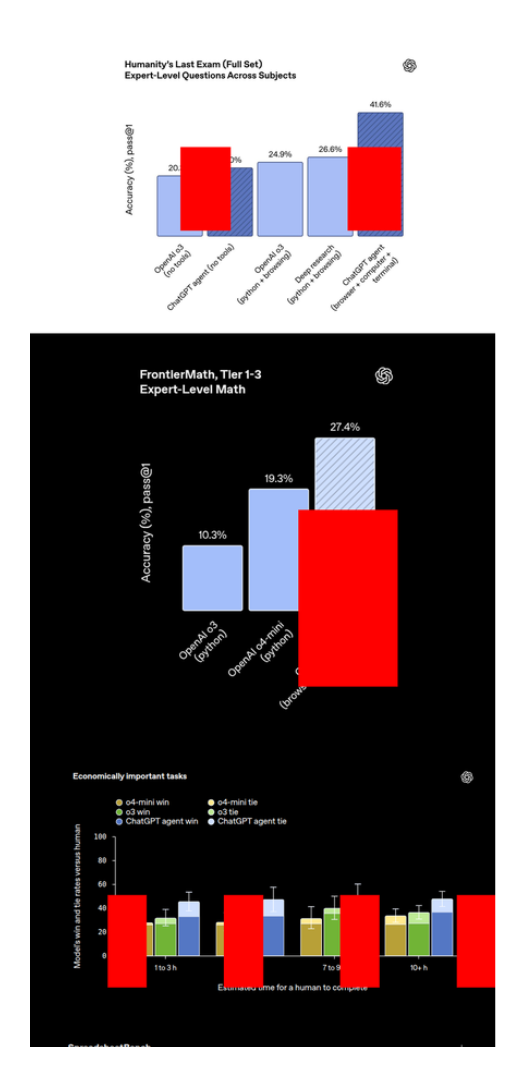

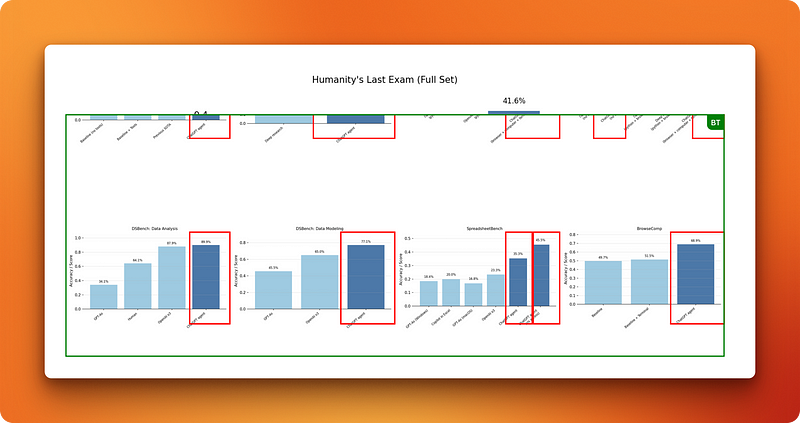

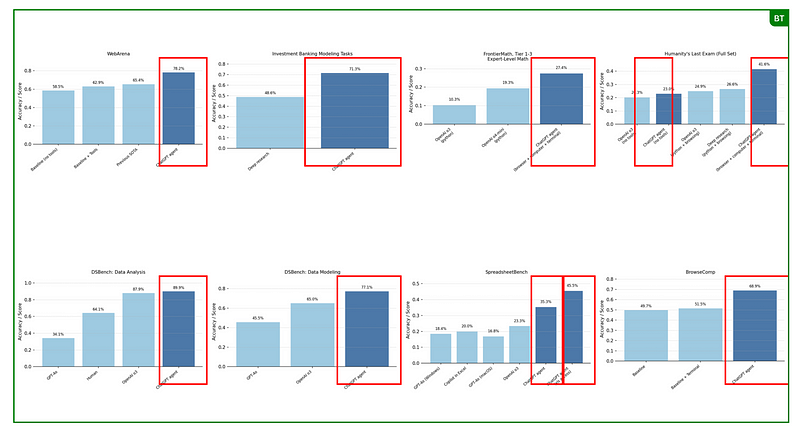

A demonstração ao vivo do ChatGPT Agent foi impressionante: navegar na web em busca de presentes, reservar viagens, criar apresentações. A publicação do anúncio mostrou resultados impressionantes em testes de benchmark, sugerindo que o Agente poderia lidar com tarefas complexas do mundo real.

Mas as demonstrações ao vivo sempre usam exemplos cuidadosamente escolhidos, e os benchmarks não capturam a complexa realidade dos fluxos de trabalho do dia a dia que a OpenAI diz que o Agente pode resolver.

Então, eu coloquei o Agente em cinco testes bem exigentes que imitam situações reais de trabalho — tarefas que exigem lidar com várias abas do navegador, cruzar informações entre diferentes sites e entregar resultados que eu realmente usaria. Esse artigo mostra o que rola quando as promessas de marketing batem de frente com a realidade.

A gente mantém nossos leitores atualizados sobre as últimas novidades em IA enviando o The Median, nosso boletim informativo gratuito às sextas-feiras, que traz as principais notícias da semana. Inscreva-se e fique por dentro em só alguns minutos por semana:

O que é o ChatGPT Agent?

O ChatGPT Agent é o recurso premium mais recente da OpenAI para usuários Plus, Pro e Enterprise. Reúne três ferramentas que antes funcionavam separadamente: Pesquisa profunda, operador e o raciocínio do modelo de linguagem central. Qual é a grande diferença? O Agente tem seu próprio computador virtual pra trabalhar.

Isso é importante porque a configuração antiga tinha problemas. O modo Pesquisa Aprofundada era ótimo pra análise, mas não dava pra clicar em nada. O operador conseguia navegar em sites, mas não tinha a capacidade de raciocínio que tornava a pesquisa aprofundada tão útil. O Agente resolve isso juntando as duas habilidades num só lugar.

O que torna o ChatGPT Agent diferente

Você vai encontrar o Agente como outra opção na barra de ferramentas do chat. Mas, diferente do ChatGPT normal, ele rola num computador virtual com acesso total a:

- Navegador para navegar na web e pesquisar

- Terminal para rodar comandos e scripts

- Ambiente de execução de código para processamento de dados

- Sistema de arquivos para baixar e organizar conteúdo

A configuração do computador virtual permite que o Agente faça coisas que antes não eram possíveis.

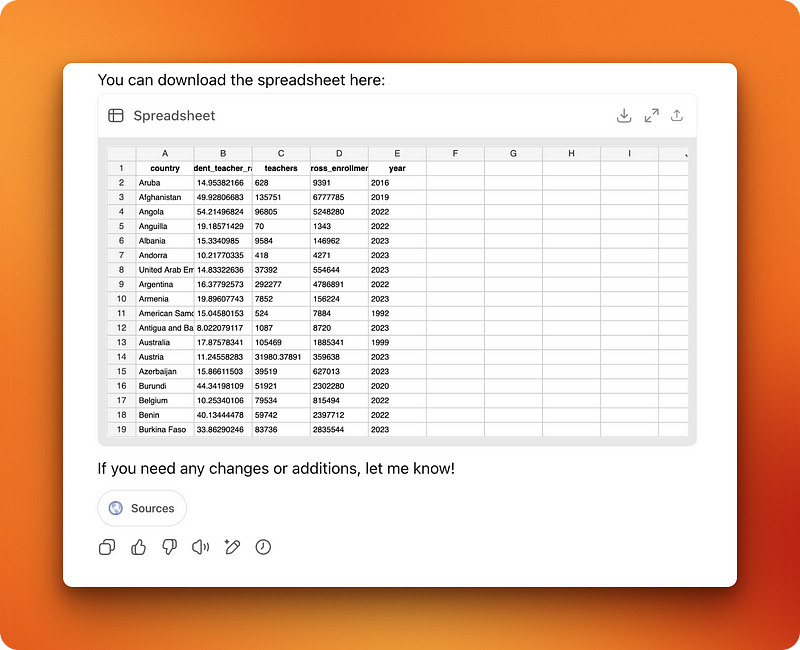

Exemplo 1: Tarefa de Dados Educacionais da UNESCO

Quando eu testei com uma tarefa de dados educacionais da UNESCO, vi que funcionou direitinho por 14 minutos. Essa foi a sugestão (dada pelo próprio ChatGPT durante minha primeira interação com o Agente):

Pull the latest available data from the UNESCO Institute for Statistics on national student-teacher ratios and total teaching staff counts for primary and secondary education.

Create a spreadsheet with two tabs: one for primary education and one for secondary.

Each should include country name, student-teacher ratio, total number of teachers, gross enrollment, and year of reporting.

Add a summary tab highlighting the countries with the most strained and most favorable ratios, sorted accordingly.

Ensure consistent country naming across tabs.Aqui está o que ele conseguiu fazer enquanto executava o comando:

- Leia páginas da web rolando como um humano (mas mais rápido) em vez de analisar HTML bruto.

- Clique nos botões, preencha formulários e — sem brincadeira — feche pop-ups e aceite cookies.

- Baixe arquivos e descompacte arquivos automaticamente

- Alterne entre o navegador e o terminal conforme necessário

- Analisar os arquivos baixados e voltar à navegação

- Baixe PDFs e extraia o conteúdo do texto

- Conserte os erros voltando às páginas anteriores.

- Controla o cursor de forma suave em diferentes interfaces

Comparação real de desempenho com o3-pro

Eu dei ao Agente e ao o3-pro o mesmo comando complexo acima: pegar os dados da UNESCO sobre a proporção aluno-professor e criar uma planilha formatada com várias abas. Os resultados mostraram diferenças claras.

O agente trabalhou por 14 minutos e entregou uma planilha com 222 países. Faltou um requisito (a aba de resumo com as melhores/piores proporções) e a lista foi organizada em ordem alfabética em vez de por proporções. Isso pode ser excesso de contexto — quando o modelo esquece os detalhes originais ao lidar com uma tarefa longa.

Por outro lado, o3-pro levou 18 minutos pra pensar no problema. Então, ele encontrou obstáculos que o Agente já tinha resolvido automaticamente. Como o o3-pro não consegue baixar arquivos, ele me pediu pra baixar dois recursos manualmente, descompactá-los e rodar um script Python que ele criou. Eu não testei o script, mas ficou claro que esse método ia adicionar pelo menos 10 minutos ao meu fluxo de trabalho.

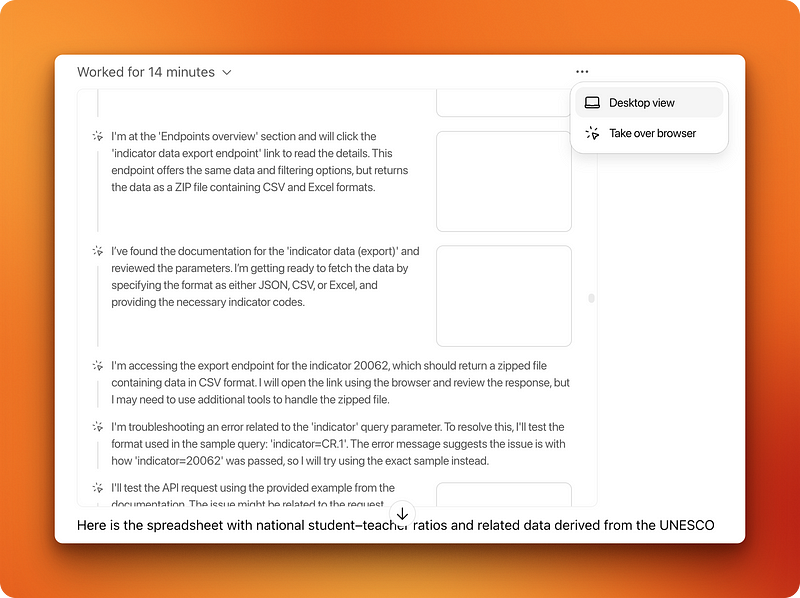

Como o Agente funciona na prática

Quando o Agente estiver rodando, você pode ver tudo que tá rolando em tempo real. Você pode assumir o controle do navegador a qualquer momento, mas para tarefas sem dados confidenciais ou interações, ele funciona bem sozinho.

Depois que o Agente terminar, você tem duas maneiras de ver o que rolou. Tem um vídeo completo que você pode pausar e reproduzir (é meio chato de assistir depois que a novidade passa). Além disso, tem uma linha do tempo detalhada com o raciocínio por trás de cada passo, os comandos que rolaram e as operações de arquivo que foram feitas.

A parte legal? Quando o agente terminar uma tarefa, você pode fazer perguntas de acompanhamento no modo de chat normal. Ele lembra tudo o que aprendeu e pode consultar os dados que coletou.

Exemplo 2: Criando uma colagem de imagens

A primeira tarefa de pesquisa mostrou que o Agente conseguia lidar com a coleta de dados complexos. Mas eu precisava testar algo diferente — tarefas que exigiam o uso constante do mouse em elementos da página da web. Se não fosse isso, eu continuaria usando meus atalhos de teclado e fazendo tudo sozinho.

Criar figuras e diagramas veio logo à minha cabeça. Faço isso muitas vezes em posts de blog, então achei que seria um teste natural.

A tarefa e a primeira tentativa

Enquanto pesquisava pra esse artigo, eu estava lendo o post de anúncio da OpenAI sobre o ChatGPT Agent. A publicação tem 6–7 imagens com os resultados dos testes de benchmark, mostrando os resultados incríveis do Agente. Em vez de listar cada benchmark individualmente, decidi pedir ao agente para criar uma colagem visual que eu pudesse adicionar a esta publicação do blog.

I want you to open the following link, combine all benchmark results' images into a single collage and highlight the columns where ChatGPT's agent results are given.

<link>

https://openai.com/index/introducing-chatgpt-agent/

</link>O que eu queria era simples: pegar todos os gráficos de referência da página da web, organizá-los lado a lado em linhas e desenhar retângulos vermelhos em torno das colunas que mostravam o desempenho do Agente. Pra qualquer um que já conhece o Canva, isso leva só alguns minutos: pega as imagens, organiza elas, desenha uns retângulos.

Mas, para um programa de IA, isso exige um raciocínio complexo e muito trabalho com o mouse. O agente demorou 9 minutos e entregou algo que não foi lá essas coisas.

A imagem estava toda na vertical, em vez de ter um layout de grade legal. Os retângulos vermelhos não eram contornos nítidos, mas formas preenchidas espalhadas por todas as imagens. Pior ainda, ele tinha ido parar em outros sites, pegando resultados de benchmark de páginas aleatórias em vez da publicação que eu tinha especificado.

Também ignorou completamente o Canva, mesmo que eu tivesse conectado à minha conta.

Segunda rodada: instruções mais detalhadas

Comecei um novo tópico com instruções mais específicas:

I want you to open the following webpage where you will find a bunch of benchmark results given in the form of images on the performance of ChatGPT Agent. Your task is to combine all those images given in the webpage (ONLY IN THAT WEBPAGE, DON'T SEARCH FOR ADDITIONAL INFORMATION) into a single collage where you organize the images side-by-side in rows. Afterward, highlight the columns where ChatGPT Agent's performance is shown with a red rectangle. Use Canva to do this task

<link>

https://openai.com/index/introducing-chatgpt-agent/

</link>Primeiro, o Agente encontrou um CAPTCHA ao tentar ler a publicação do anúncio. Tive que assumir o controle e escolher as imagens das faixas de pedestres sozinho. Depois, funcionou por 18 minutos antes de parar e pedir pra eu entrar no Canva.

A experiência de login não foi muito boa. O computador virtual e o navegador ficam lentos — nada a ver com a resposta rápida que você espera ao entrar em sites. Os atalhos de teclado, tipo Cmd + V pra colar senhas, demoram mais pra funcionar.

Onde as coisas deram errado

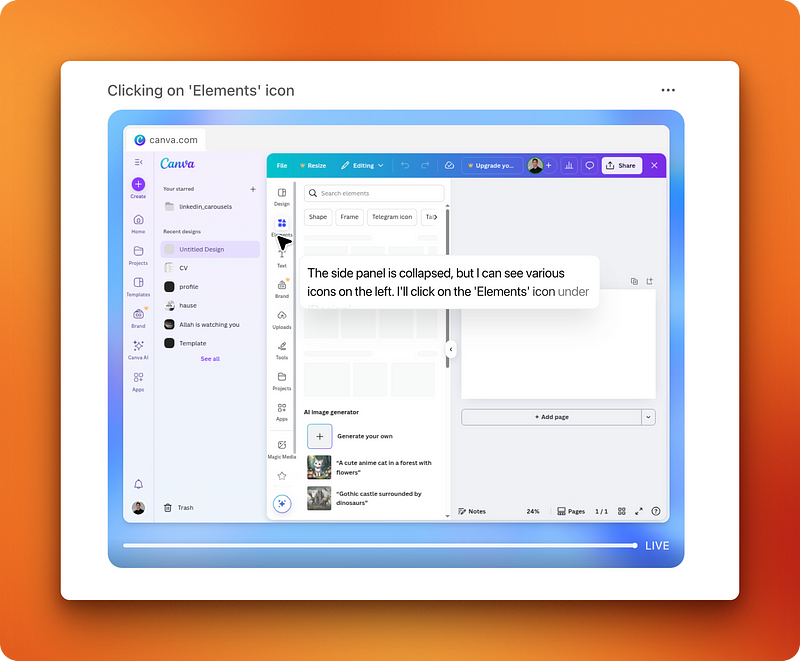

Depois que o Agent entrou no Canva, ele voltou a funcionar na interface.

Depois de 8 minutos vendo ele se atrapalhar sem saber o que fazer, tive que dar uma força. O agente estava tentando desenhar manualmente as imagens dos resultados de referência, uma por uma, em vez de usar as imagens baixadas de verdade.

Eu esclareci com outra pergunta:

No, you are going in the wrong direction on Canva.

What I meant was that after you grabbed the benchmark results' images, paste them into canva and organize them one-by-one into a 16:9 collage with ChatGPT Agent's performance highlighted with a red rectangleDesta vez, o Agente entendeu, mas ficou claro que ele não sabia bem como fazer a tarefa.

Demorou um pouco pra eu reler o post do anúncio e baixar as imagens de referência. O download foi super lento — o Agente ficava na dúvida se devia usar “Copiar link da imagem”, “Salvar imagem” ou outras opções do menu do botão direito do mouse, em vez do botão “Baixar imagem” no canto superior direito.

Depois de finalmente enviar as imagens para o Canva, o agente começou o trabalho de layout propriamente dito. Isso mostrou como o controle espacial deles é ruim. Ver o programa tentando arrastar imagens para o lugar certo era como ver uma criança usando um computador. Ele ficava perdendo os alinhamentos e as posições naturais onde os elementos deveriam estar.

Outro problema apareceu quando o Agente tentou desenhar retângulos em volta das barras de referência. Para nós, isso é bem fácil — basta passar o mouse e desenhar um retângulo. Para o Agente, isso virou uma tarefa difícil. Como não tem inteligência espacial e visual, ele usou scripts Python e OCR pra detectar quais barras mostravam o desempenho do Agente e, depois, calculou as coordenadas exatas pra colocar os retângulos.

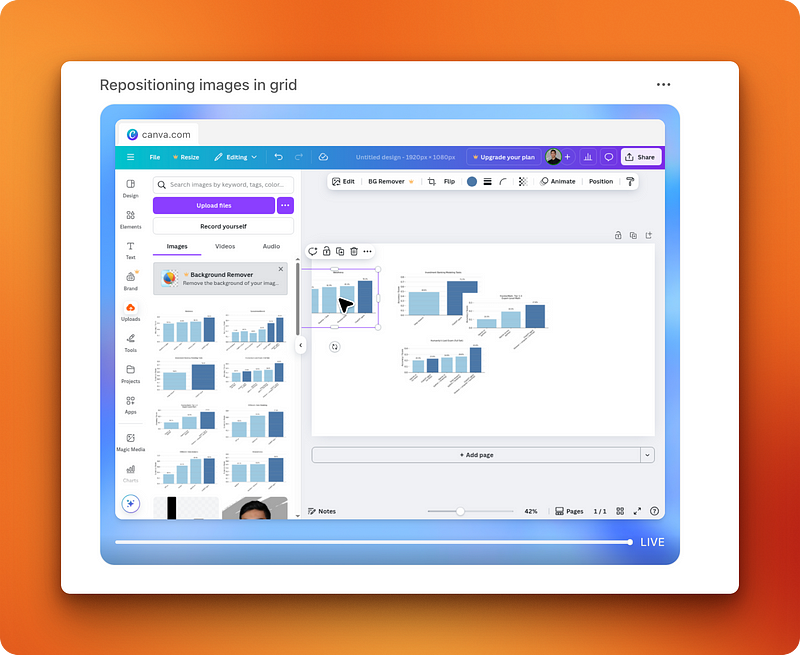

O resultado final

A operação toda levou mais de 75 minutos, incluindo todas as idas e vindas. O agente deixou uma “Página de design sem título 2” na minha conta do Canva.

A imagem parecia cortada porque o agente tentou adicionar um elemento de texto de título, o que, de alguma forma, fez com que a parte superior fosse ocultada. Depois de redimensionar manualmente, consegui uma colagem funcional, mas ainda bem rudimentar em comparação com o que até mesmo um designer inexperiente conseguiria produzir em poucos minutos.

O tempo que a gente gastou não valeu a pena pelo resultado. Pra piorar, depois descobri que o agente nem tinha usado as ferramentas de retângulo do Canva — ele desenhou os retângulos no Python e depois mandou a imagem modificada pro Canva. Isso significava que eu não poderia ajustar ou mover esses retângulos tortos manualmente mais tarde.

Introdução aos agentes de IA

Exemplo 3: Criando uma imagem de capa simples

Nesse momento, percebi que tinha pedido uma tarefa muito complicada pro Agente. A criação da colagem envolveu muitas etapas — extração de dados da web, raciocínio espacial, manipulação de várias imagens e um trabalho de design bem preciso, tudo ao mesmo tempo.

Então, tentei algo mais simples: criar imagens de capa para posts do blog. Na verdade, essa é uma tarefa que eu não gosto de fazer, então se o agente pudesse cuidar disso, seria muito útil.

Mantive os requisitos básicos: Tô escrevendo um tutorial sobre o novo Modo Agente do ChatGPT. A tua tarefa é criar uma imagem de capa em formato 16:9 usando as cores da marca DataCamp para o tutorial. Tem que incluir a palavra-chave “ChatGPT Agent” e qualquer figura robótica que você encontrar ao lado dessa palavra-chave. Use o Canva pra fazer isso.

Um sucesso mais fácil de lidar

Dessa vez, consegui resultados muito melhores. O agente procurou corretamente as cores da marca DataCamp e adicionou os dois elementos lado a lado no Canva. O alinhamento dos elementos ainda estava errado — o texto e as imagens não estavam bem posicionados em relação uns aos outros —, mas pelo menos usavam elementos reais do Canva.

Isso significava que, em vez de carregar um design pré-criado, eu podia facilmente arrastá-los para posições melhores. Depois de alguns ajustes rápidos, consegui uma imagem de capa que dava pra usar.

Um detalhe interessante: mesmo tendo feito login no Canva durante a tarefa complexa anterior em uma conversadiferente do chat, o Agent não me pediu para fazer login de novo aqui. Parece que o computador virtual guarda o histórico do navegador, os cookies e as informações de login entre as sessões. Isso é bem prático para fluxos de trabalho, mas é bom saber se você não quer que o ChatGPT guarde essas informações — você vai precisar apagar manualmente.

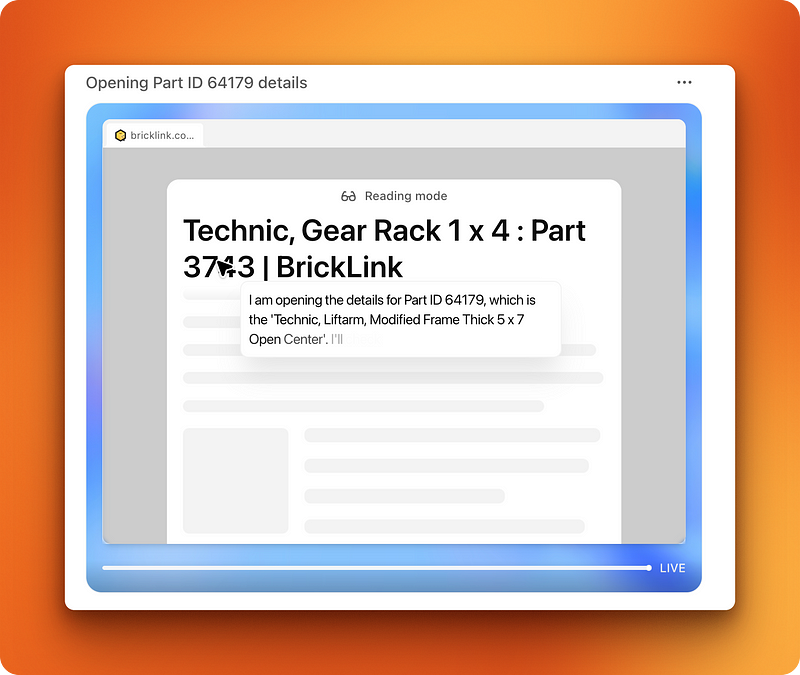

Exemplo 4: Pesquisa de peças Lego

Dessa vez, resolvi testar o Agente em algo que me deu trabalho no passado. Sou um AFOL (fã adulto de Lego) e, há alguns meses, pedi ao ChatGPT para gerar um arquivo CSV para um pacote inicial de 10.000 peças Lego Technic usando o modelo o3.

É difícil gerar arquivos CSV longos com LLMs porque tem muitos detalhes pequenos pra acompanhar. Então, quando ele gerou um arquivo CSV com pelo menos 50 partes diferentes, seus IDs, nomes e valores, percebi que ele estava com muitos erros em alguns IDs de peças, mesmo tendo acesso à pesquisa na web.

Minha pesquisa acabou aí porque eu não tive paciência pra conferir cada ID de peça e garantir que elas realmente existiam e que combinavam com a peça que a o3 queria que eu comprasse no BrickLink, um site oficial de peças e conjuntos Lego.

Preparando o teste

Mas agora que eu tinha acesso ao Agent, que podia fazer a verificação dupla por mim, pedi ao o3 um arquivo CSV de novo, mas com uma coleção menor, de 3.000 peças, pra ficar mais simples:

I want you to generate me a 3000-piece bulk pack for getting started with Lego Technic.

I am interested in building cars and motorized mechanisms as a hobby.

The bulk pack you generate must be saved to a CSV file with the following columns:

- Part ID

- Part name

- Amount

Use the official part IDs and names so that when I upload the CSV to bricklink, I can place an order with a single clickA modelo pensou por 5 minutos e me deu o arquivo CSV. Depois, mudei para um novo tópico (porque descobri que o modo Agente fica desativado quando a primeira mensagem em um tópico de chat não é para o Agente).

A tarefa de verificação

Eu carreguei o arquivo e escrevi o seguinte prompt:

I attached a 3,000-piece Lego Technic starter pack list. Your task is to double-check that each part listed in the list actually exists and that part IDs actually match part names. You must use BrickLink website (only BrickLink) as a single source of truth.

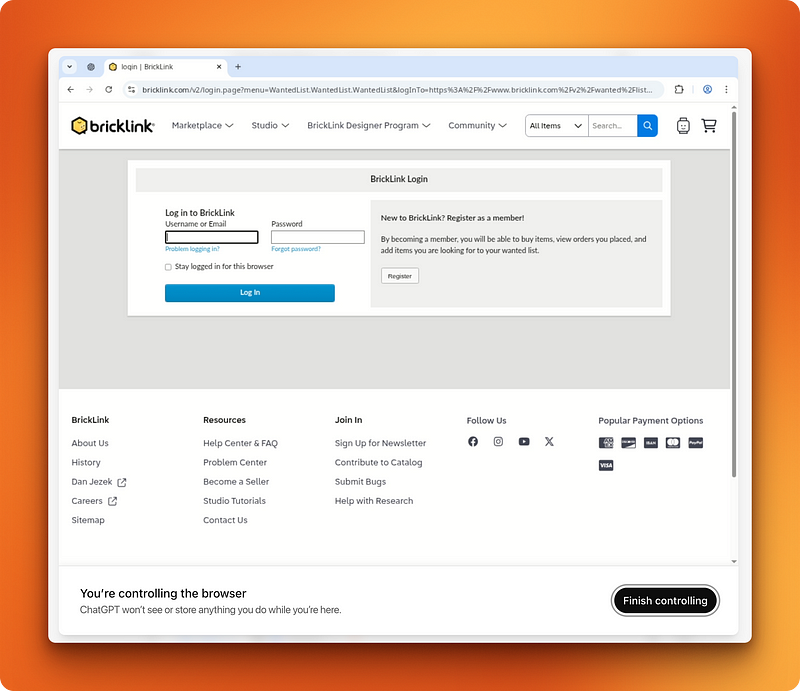

If certain part IDs or names are incorrect, correct them. Afterward, create a wishlist on BrickLink that will allow me to one-click order them later. When creating the wishlist, ask me to log in to BrickLink and I will do that for you.

E lá foi o agente. Depois de 5 minutos no site BrickLink, descobri que três peças tinham nomes diferentes no site e corrigi isso. Esse era exatamente o tipo de trabalho chato de verificação que eu queria evitar fazer sozinho.

Onde o fluxo de trabalho deu errado

Depois, pediu pra eu fazer login pra criar uma lista de desejos na minha conta. Entrei com minhas credenciais e o agente assumiu o controle pra criar uma lista de desejos.

Antes de clicar no botão final “Criar lista de desejos”, ele me pediu para confirmar, como é normal antes de operações importantes como essa. Respondi que sim, e foi aí que o fluxo de trabalho deu pau.

O agente disse que criou a lista de desejos, mas quando eu fui na minha conta, não tinha nada disso. Na verdade, era pra apertar o botão final de criar lista de desejos e depois mandar o arquivo CSV pra terminar a tarefa. Mas essa última parte foi deixada de fora.

Um sucesso parcial

Mas, claro, a parte difícil — a pesquisa em si, que exigia mudar do CSV para o BrickLink e depois voltar para o CSV várias vezes — foi feita direitinho pelo Agente. Ele conseguiu verificar várias identificações de peças, achou as inconsistências nos nomes e corrigiu tudo. Isso me poupou horas de trabalho manual de referência cruzada.

O problema rolou bem no final, na hora de criar a lista de desejos, provavelmente porque o agente não entendeu direito o processo de upload em várias etapas do BrickLink. Mesmo sendo frustrante, o valor principal foi entregue: Agora eu tinha um arquivo CSV verificado com os IDs corretos das peças, que eu mesmo poderia enviar manualmente para o BrickLink.

Exemplo 5: Criação de apresentações de slides

Por fim, eu queria testar os recursos do PowerPoint do Agent, já que o post de anúncio mencionava a criação de apresentações como um dos usos reais do Agent. PowerPoint é algo que eu evito a todo custo e uso Gamma se for preciso fazer uma apresentação.

Agora, eu queria ver se o Agente estava no mesmo nível do Gamma. Essa foi a minha sugestão:

I want you to build me a presentation pitch deck for convincing existing Manus users to the newly released ChatGPT Agent.

Here is the announcement post that you can use for information: https://openai.com/index/introducing-chatgpt-agent/Logo, o agente fez uma pergunta pra saber mais:

Do you have any specific preferences for slide count, visual style, or key points you'd like emphasized?Ao que eu respondi:

Yes, keep it to 10 slides max, use a minimalistic white, black and red (gradients are allowed) for the style.

If possible, look for direct comparisons between Manus and ChatGPT AgentUma abordagem diferente que funcionou

O agente trabalhou na apresentação por 13 minutos. Curiosamente, não usou o Google Slides, mas sim o terminal para rodar uma combinação de código Python e JavaScript!

Dá uma olhada na apresentação aqui.

O resultado foi muito melhor do que esperávamos. Eu tava esperando outro fracasso tipo o Canva, porque apresentações envolvem alinhar elementos numa página. Mas como o Agente só usou a execução de código, ele conseguiu achar as coordenadas exatas dos elementos sozinho e abrir a apresentação de verdade pra conferir o trabalho e ajustar o rumo, se fosse preciso.

Comparando o desempenho com o Gamma

É por isso que demorou 13 minutos pra fazer essa apresentação. Isso leva muito mais tempo do que o Gamma, mas com o Gamma você mesmo precisa colocar os dados em formato de texto. O Agente pode procurar os dados por conta própria de forma dinâmica.

Então, isso ainda é bem legal, mas eu diria que dá pra melhorar, principalmente em ambientes profissionais onde o risco é alto. Os slides pareciam profissionais e o conteúdo estava bem estruturado, mas a formatação poderia ser mais refinada para apresentações ao cliente.

Minha opinião sobre os agentes ChatGPT

Antes de testar o Agente, eu não esperava muito pra não ficar decepcionado. Essa foi uma boa estratégia, porque o Agente não conseguiu fazer as tarefas que eu mais tenho dificuldade.

Mas é super promissor — me fez perceber que ainda estamos no começo da era dos agentes que conseguem usar computadores e navegadores como a gente. A infraestrutura principal tá aqui. O software opera um computador virtual e um navegador, mas é limitado pela natureza dos modelos atuais.

A OpenAI não dá muitos detalhes sobre o modelo de aprendizado por reforço que alimenta o Agente. Mesmo sendo otimizado para controle por computador, eu acho que as falhas do Agente são por causa desse modelo básico. Ele ainda precisa ver o mundo através de uma lente textual, mesmo que consiga processar imagens e capturas de tela.

É por isso que ele tem dificuldade com movimentos do mouse e tarefas espaciais. O Agente consegue ver onde os elementos estão posicionados numa página web, mas tem de traduzir essa informação visual em comandos baseados em coordenadas, em vez de operar através da coordenação visual-motora direta que os humanos utilizam. Quando você arrasta uma imagem no Canva, não está calculando coordenadas de pixels — você está usando a intuição espacial. O agente não tem essa compreensão intuitiva do espaço digital.

Essa limitação básica explica por que o Agente se saiu bem em tarefas de pesquisa e verificação de dados, mas teve dificuldades com o trabalho de design e a manipulação precisa da interface. O futuro dos agentes controlados por computador provavelmente vai precisar de novas arquiteturas que possam preencher essa lacuna entre a compreensão visual e a interação espacial.

Por enquanto, o ChatGPT Agent funciona melhor quando você consegue definir o sucesso através da lógica, em vez da estética, e quando a tarefa envolve processamento de informações, em vez de arranjos espaciais criativos.

Conclusão

O ChatGPT Agent é um assistente virtual que rola num computador em uma área isolada, juntando navegação na web, execução de código e gerenciamento de arquivos. Embora o desempenho seja meio irregular — bom em pesquisa e tarefas com dados, mas meio ruim com trabalhos visuais ou que exigem muita interface —, é uma boa prévia de como as ferramentas de IA do futuro podem interagir com softwares por nós.

Para saber mais sobre agentes, recomendo os seguintes recursos:

Sou um criador de conteúdo de ciência de dados com mais de 2 anos de experiência e um dos maiores seguidores no Medium. Gosto de escrever artigos detalhados sobre IA e ML com um estilo um pouco sarcástico, porque você precisa fazer algo para torná-los um pouco menos monótonos. Produzi mais de 130 artigos e um curso DataCamp, e estou preparando outro. Meu conteúdo foi visto por mais de 5 milhões de pessoas, das quais 20 mil se tornaram seguidores no Medium e no LinkedIn.