GPT-4 es la IA generativa más avanzada desarrollada por OpenAI. Está cambiando el panorama de cómo trabajamos. Sin embargo, GPT-4 no es de código abierto, lo que significa que no tenemos acceso al código, la arquitectura del modelo, los datos o los pesos del modelo para reproducir los resultados. No podemos crear nuestro propio GPT-4 como un chatbot.

Para equilibrar la balanza, las comunidades de código abierto han empezado a trabajar en alternativas a GPT-4 que ofrecen un rendimiento y una funcionalidad similares y requieren menos recursos informáticos.

Puedes aprender sobre GPT-1, GPT-2, GPT-3 y GPT-4 revisando: ¿Qué es GPT-4 y por qué es importante?, o puedes aprender a utilizar ChatGPT para proyectos de ciencia de datos y dominar la ingeniería de prompts para mejorar en la construcción de proyectos de ciencia de datos de principio a fin.

En el artículo, presentaremos 12 alternativas a GPT-4 con una breve descripción y enlaces al artículo científico pertinente, a la entrada del blog, a la demo del chatbot, al código fuente y a la tarjeta modelo.

Nota: Algunos de los modelos mencionados tienen una licencia no comercial, que restringe su uso exclusivamente a fines académicos y de investigación. Debes comprender estas limitaciones antes de utilizarlos.

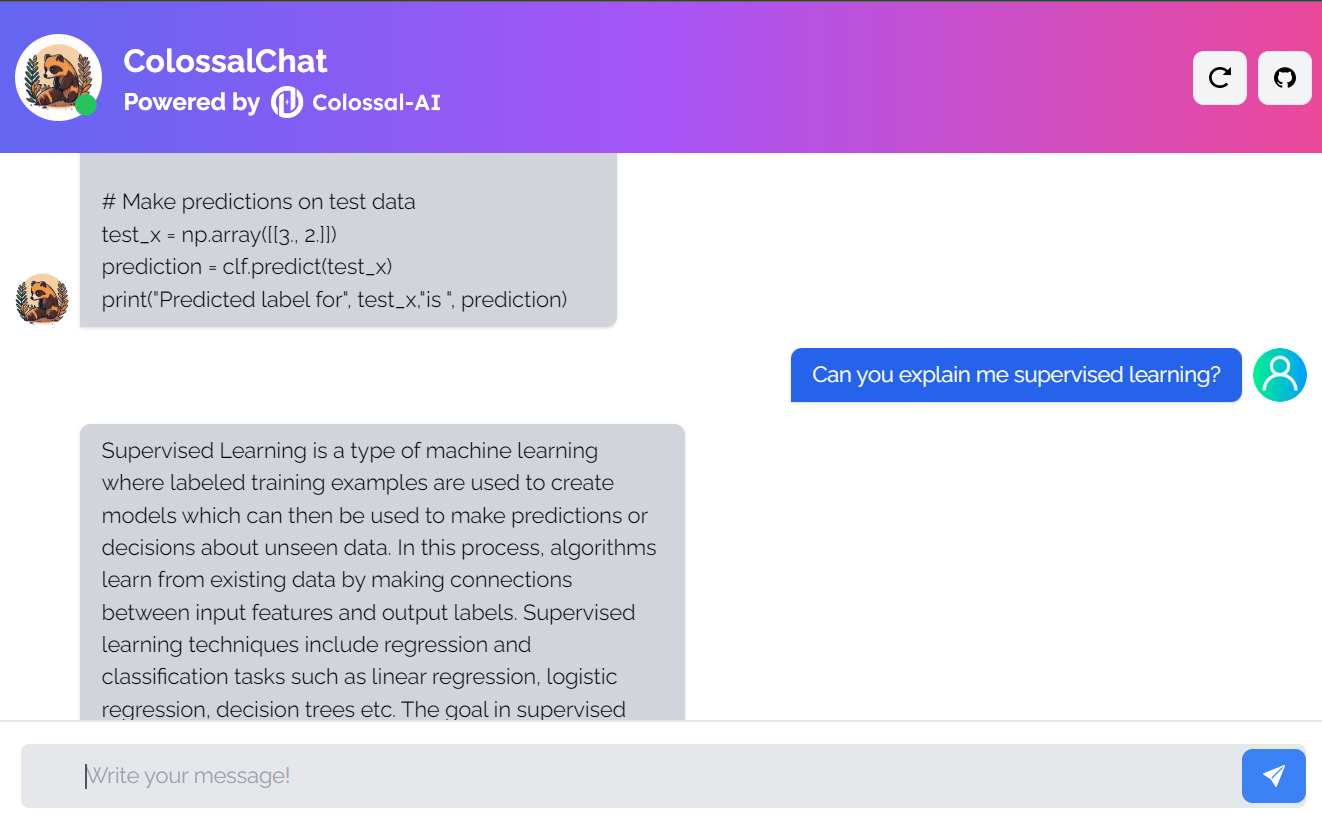

1. ColossalChat

ColossalChat es un proyecto de código abierto que te permite clonar modelos de IA utilizando un pipeline completo de RLHF (aprendizaje por refuerzo a partir de la retroalimentación humana).

Es un proyecto completamente de código abierto que incluye el conjunto de datos bilingües, el código de entrenamiento, la demo y la inferencia cuantificada de 4 bits. Todos los componentes te ayudarán a crear un chatbot personalizado más barato y más rápido.

Imagen de ColossalChat

- Artículo científico: Colossal-AI: Un sistema unificado de aprendizaje profundo para el entrenamiento paralelo a gran escala

- Entrada del blog: ColossalChat: Una solución de código abierto para clonar ChatGPT con un pipeline completo de RLHF

- GitHub: hpcaitech/ColossalAI

- Demo: ColossalChat (colossalai.org)

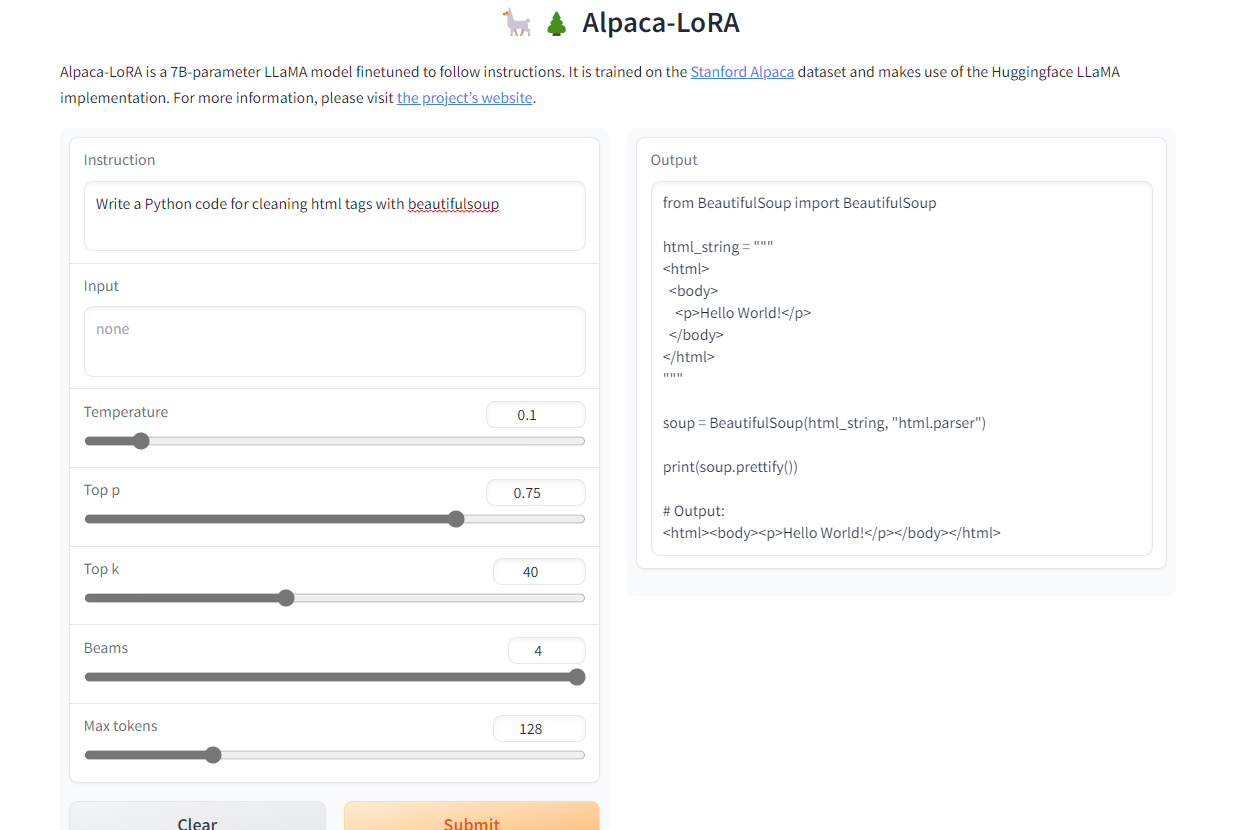

2. Alpaca-LoRA

Alpaca-LoRA es un modelo creado utilizando Stanford Alpaca y adaptación de bajo rango (LoRA). La adopción del bajo rango nos permite ejecutar un modelo Instruct de calidad similar a GPT-3.5 en Raspberry Pi 4 de 4 GB de RAM.

El proyecto proporciona código fuente, ejemplos de ajuste, código de inferencia, pesos del modelo, conjunto de datos y demo. Lo mejor es que podemos entrenar nuestro modelo en unas pocas horas con una sola RTX 4090.

Imagen de Alpaca-LoRA

- GitHub: tloen/alpaca-lora

- Tarjeta modelo: tloen/alpaca-lora-7b

- Demo: Alpaca-LoRA

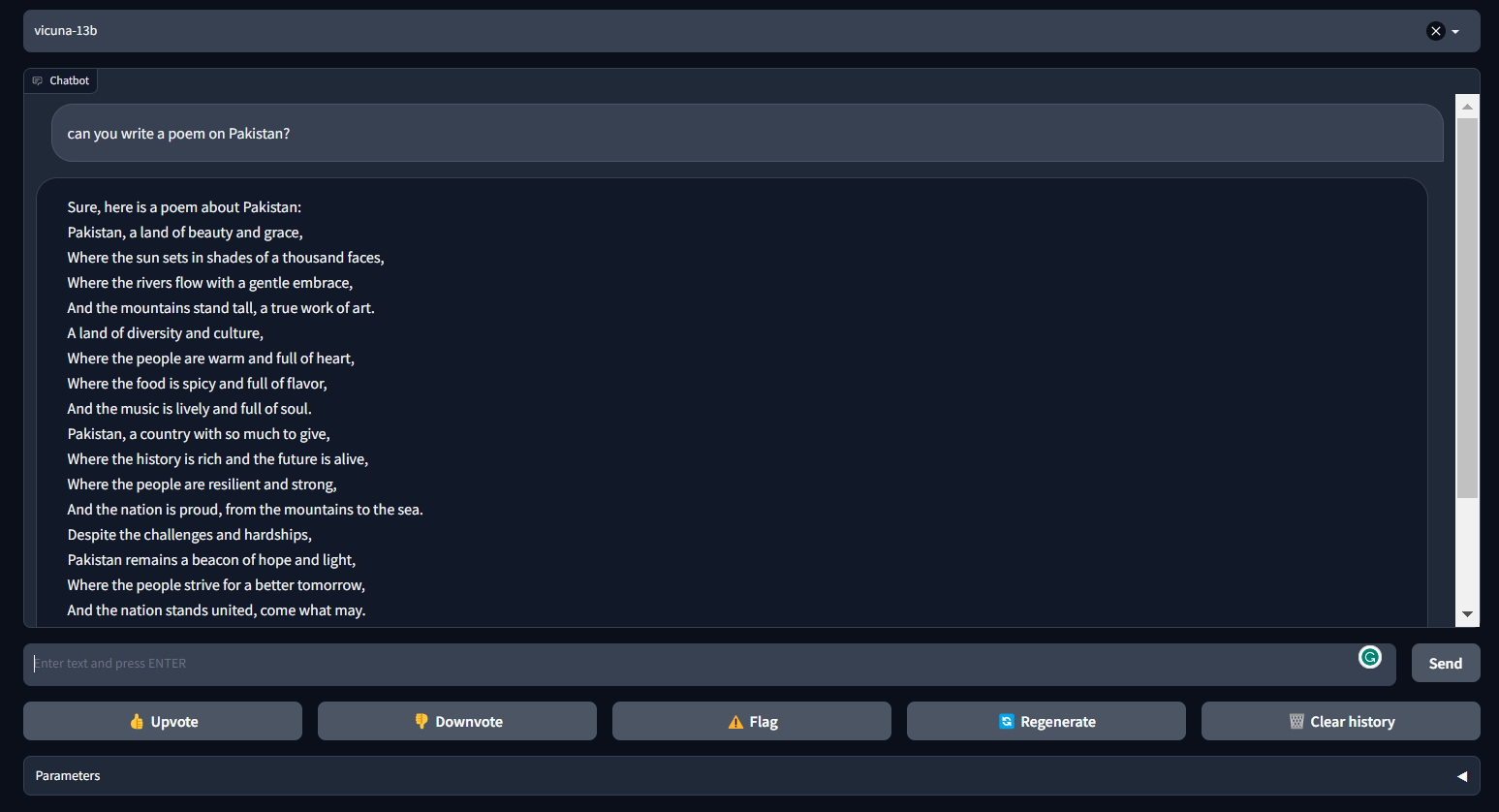

3. Vicuna

Vicuna puede generar textos coherentes y creativos para los chatbots. Se trata de una arquitectura basada en transformadores que se afinó en un conjunto de datos conversacionales recogidos de ShareGPT.com.

Vicuna proporciona casi el 90 % del rendimiento de ChatGPT. Forma parte de FastChat, una plataforma abierta que permite a los usuarios entrenar, servir y evaluar sus chatbots. FastChat proporciona todos los componentes y herramientas necesarios para construir un modelo de chatbot personalizado.

Imagen de FastChat (lmsys.org)

- Entrada del blog: Vicuna: Un chatbot de código abierto que impresiona a GPT-4 con un 90 %* de la calidad de ChatGPT | por un equipo con miembros de UC Berkeley, CMU, Stanford y UC San Diego

- GitHub: lm-sys/FastChat

- Demo: FastChat (lmsys.org)

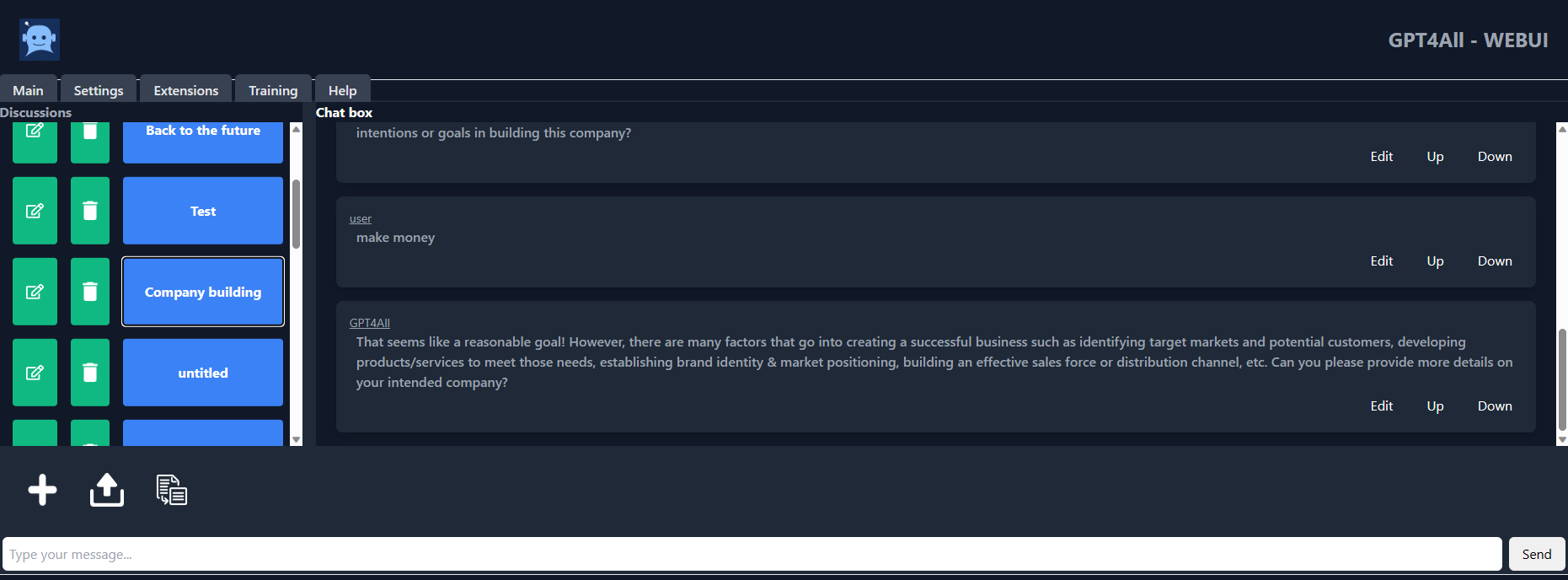

4. GPT4ALL

GPT4ALL es un chatbot desarrollado por el equipo de IA de Nomic sobre datos masivos curados de interacción asistida como problemas verbales, código, historias, representaciones y diálogo multiturno. La arquitectura del modelo se basa en LLaMa, y utiliza aceleradores de machine learning de baja latencia para una inferencia más rápida en la CPU.

Con GPT4ALL, tienes un cliente Python, interferencia de GPU y CPU, enlaces Typescript, una interfaz de chat y un back-end Langchain.

Imagen de gpt4all-ui

- Informe técnico: GPT4All

- GitHub: nomic-ai/gpt4al

- IU de chatbot: nomic-ai/gpt4all-ui

- Tarjeta modelo: nomic-ai/gpt4all-lora

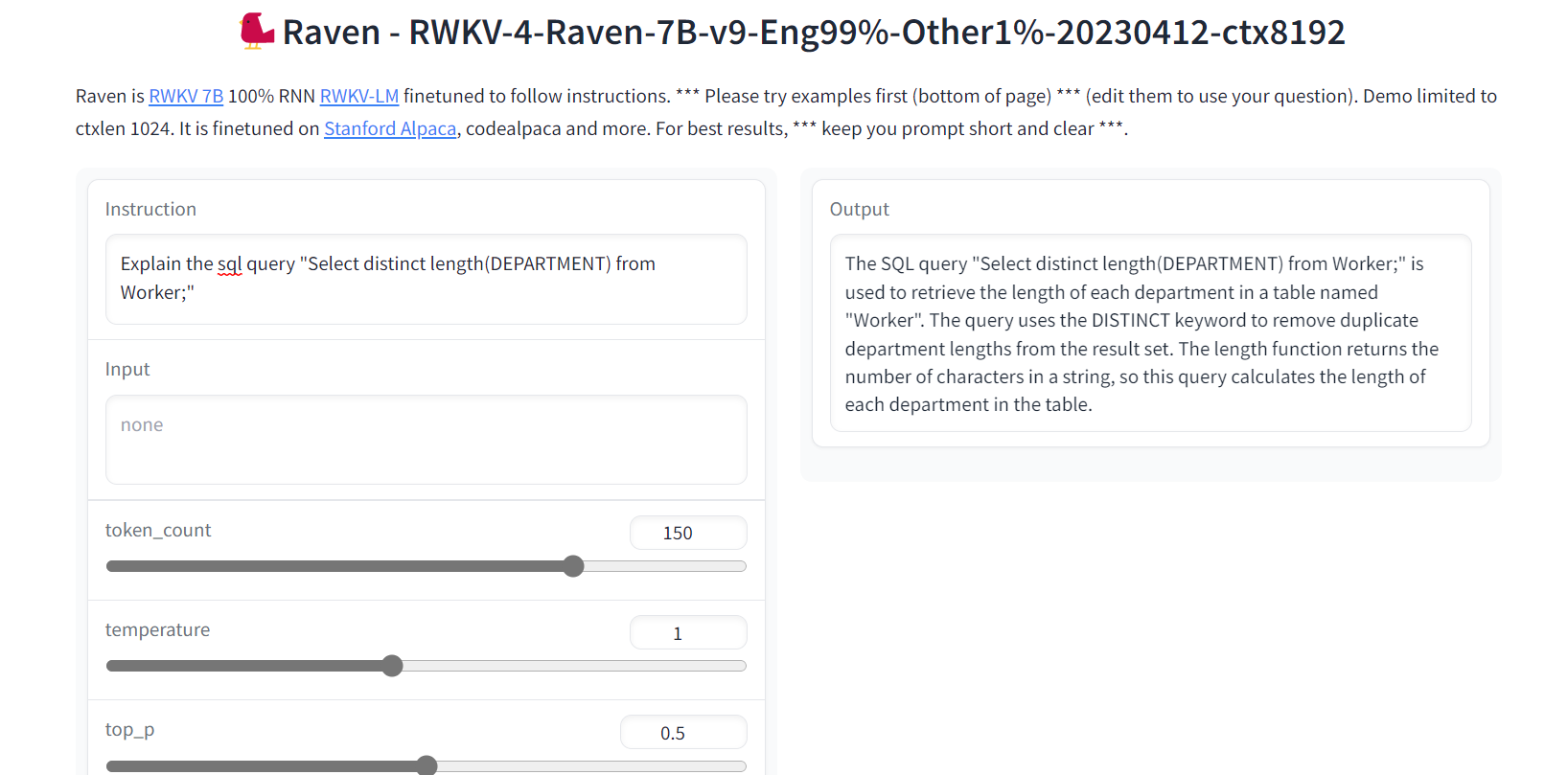

5. Raven RWKV

Raven RWKV forma parte de ChatRWKV, que es un modelo de código abierto como ChatGPT, pero impulsado por el modelo de lenguaje RWKV (100 % RNN), no basado en transformadores.

Al utilizar RNN, el modelo alcanza niveles de calidad y escalabilidad comparables a los de los transformadores, con las ventajas añadidas de una mayor velocidad de procesamiento y conservación de la VRAM. Raven se afinó para seguir instrucciones, y se afinó en Stanford Alpaca, code-alpaca y más conjuntos de datos.

Imagen de Raven RWKV 7B

- GitHub: BlinkDL/ChatRWKV

- Demo: Raven RWKV 7B

- Tarjeta modelo: BlinkDL/rwkv-4-raven

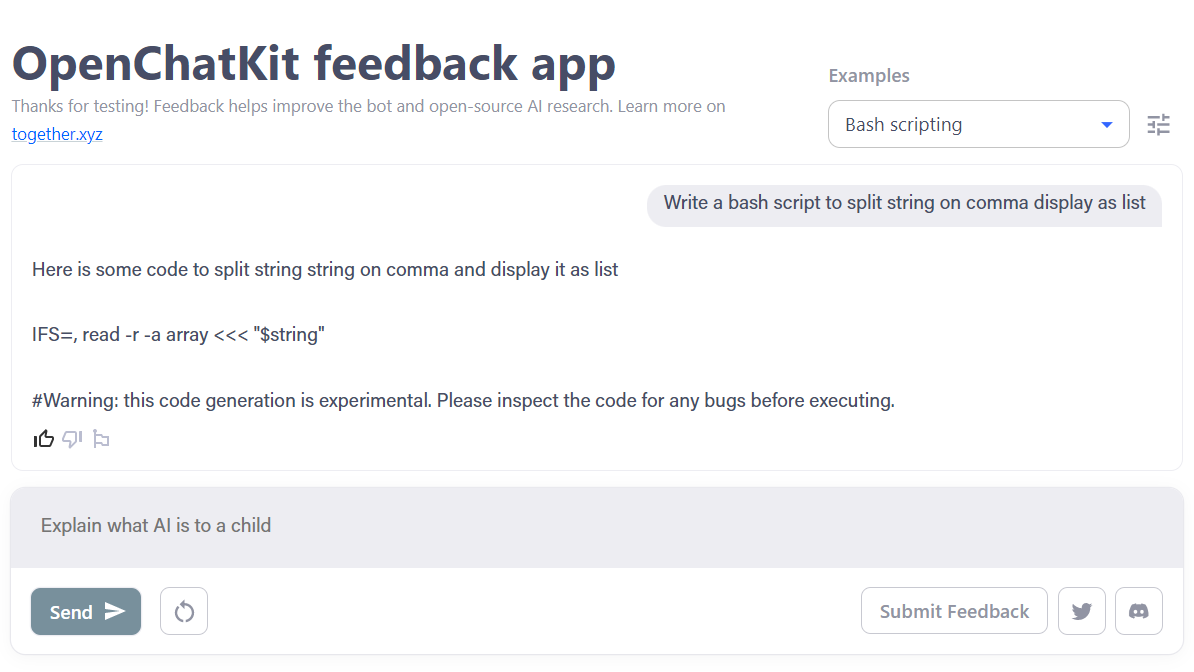

6. OpenChatKit

OpenChatKit es un completo conjunto de herramientas que ofrece una alternativa de código abierto a ChatGPT para desarrollar la aplicación de chatbot.

El conjunto de herramientas incluye instrucciones paso a paso para entrenar tu propio gran modelo de lenguaje ajustado a las instrucciones y afinar el modelo y un sistema de recuperación extensible para actualizar las respuestas del bot. Además, incluye funciones de moderación que pueden ayudar a filtrar las preguntas inapropiadas.

Imagen de OpenChatKit

- Entrada del blog: Anuncio de OpenChatKit - TOGETHER

- GitHub: togethercomputer/OpenChatKit

- Demo: OpenChatKit

- Tarjeta modelo: togethercomputer/GPT-NeoXT-Chat-Base-20B

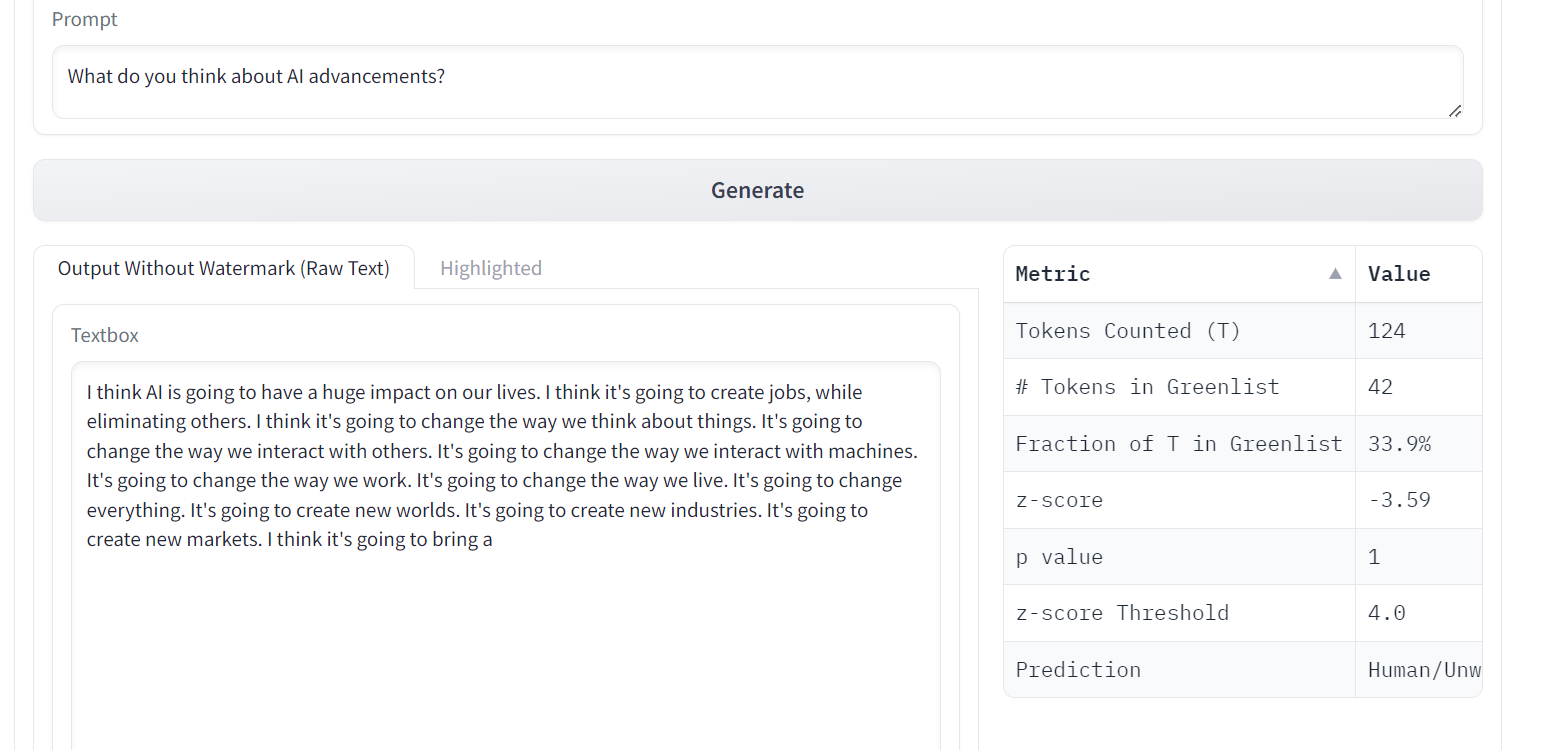

7. OPT

Los modelos lingüísticos OPT (Open Pre-trained Transformer) han demostrado notables capacidades en el aprendizaje con cero muestras de entrenamiento y pocas muestras de entrenamiento, así como en el análisis de sesgos estereotipados, a pesar de no igualar la calidad de ChatGPT.

OPT es una familia de grandes modelos lingüísticos que van de 125 millones a 175 000 millones de parámetros. Los modelos son transformadores solo decodificadores, lo que significa que generan texto autorregresivo de izquierda a derecha.

Imagen de Una filigrana para los LLM

- Artículo científico: OPT: Modelos lingüísticos Open Pre-trained Transformer

- GitHub: facebookresearch/metaseq

- Demo: Una filigrana para los LLM

- Tarjeta modelo: facebook/opt-1.3b

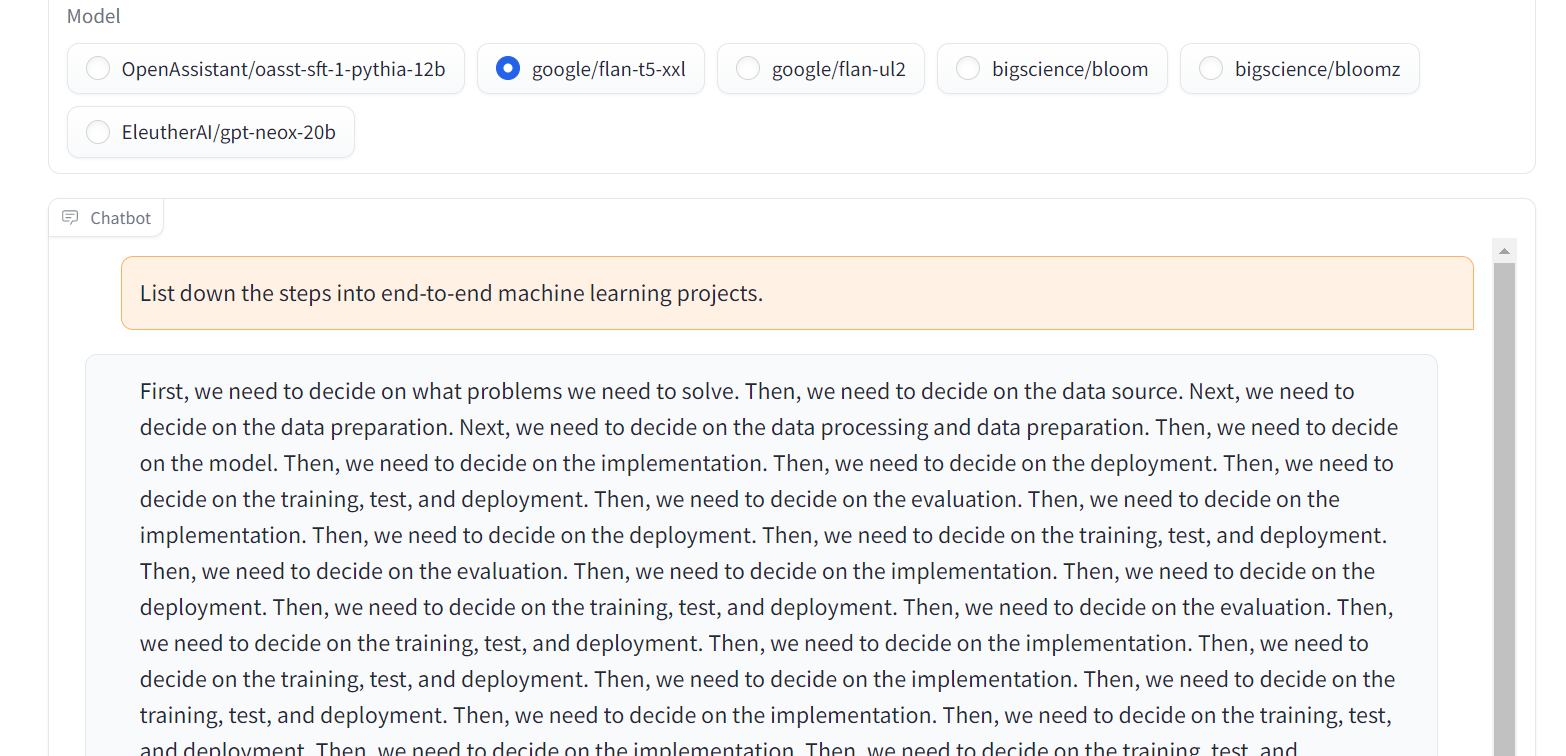

8. Flan-T5-XXL

Flan-T5-XXL eran modelos T5 afinados que se han entrenado con una amplia colección de conjuntos de datos presentados en forma de instrucciones. Este tipo de ajuste fino ha mejorado significativamente el rendimiento en diversas clases de modelos, como PaLM, T5 y U-PaLM. Además, el modelo Flan-T5-XXL se afinó en más de 1000 tareas adicionales que abarcaban varios lenguajes.

Imagen de Chat Llm Streaming

- Artículo científico: Modelos lingüísticos afinados con instrucciones a escala

- GitHub: google-research/t5x

- Demo: Chat Llm Streaming

- Tarjeta modelo: google/flan-t5-xxl

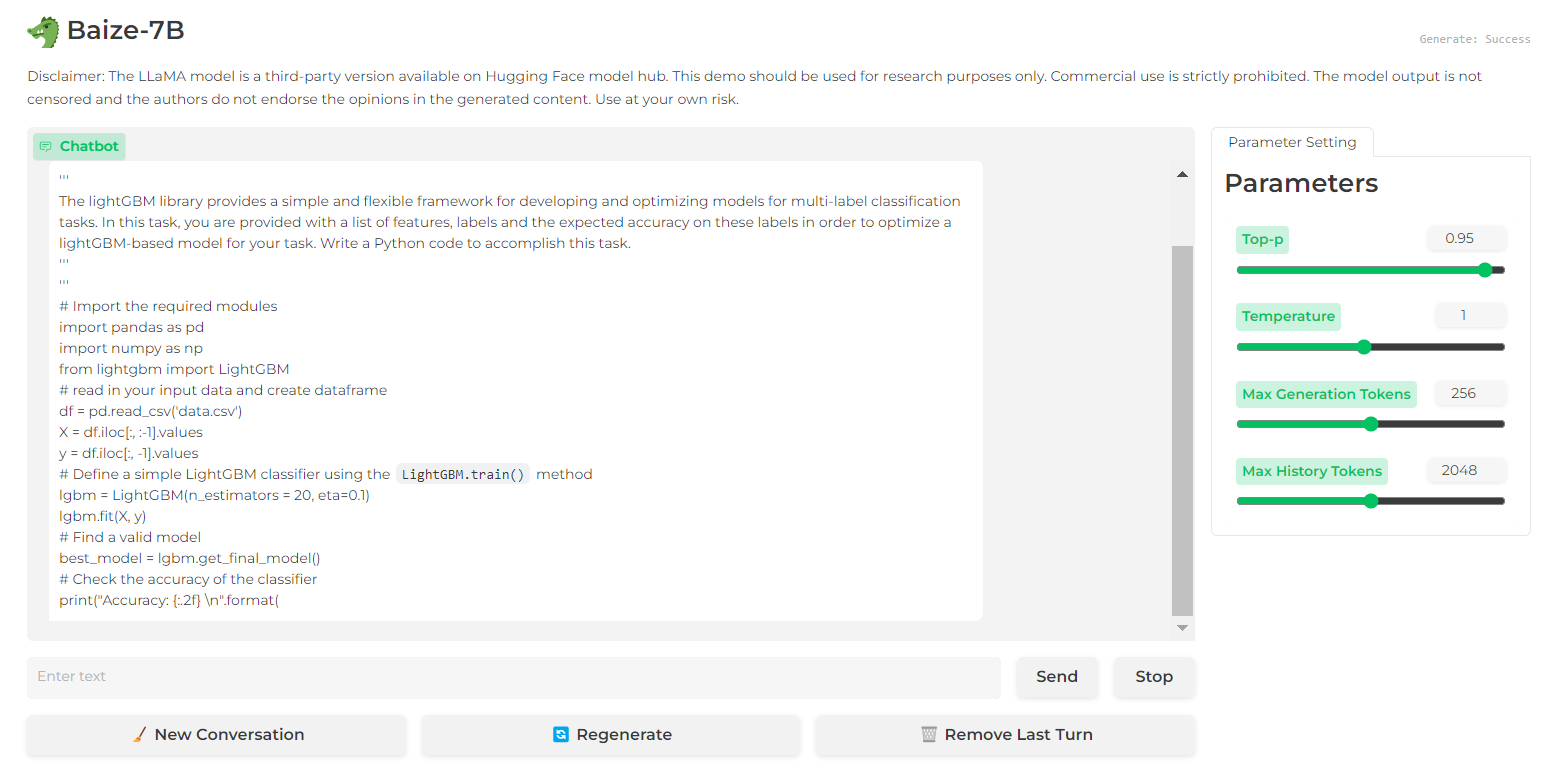

9. Baize

Baize muestra un rendimiento impresionante en los diálogos multiturno gracias a sus guardrails que ayudan a mitigar los riesgos potenciales. Lo ha conseguido mediante un corpus de chat multiturno de alta calidad, que se desarrolló aprovechando ChatGPT para facilitar conversaciones consigo mismo.

El código fuente, el modelo y el conjunto de datos de Baize se publican bajo una licencia no comercial (con fines de investigación).

Imagen de Baize 7B

Imagen de Baize 7B

- Artículo científico: Baize: Un modelo de chat de código abierto con ajuste eficiente de parámetros sobre datos de autochat

- GitHub: proyecto-baize/baize-chatbot

- Demo: Baize 7B

- Tarjeta modelo: project-baize/baize-lora-7B

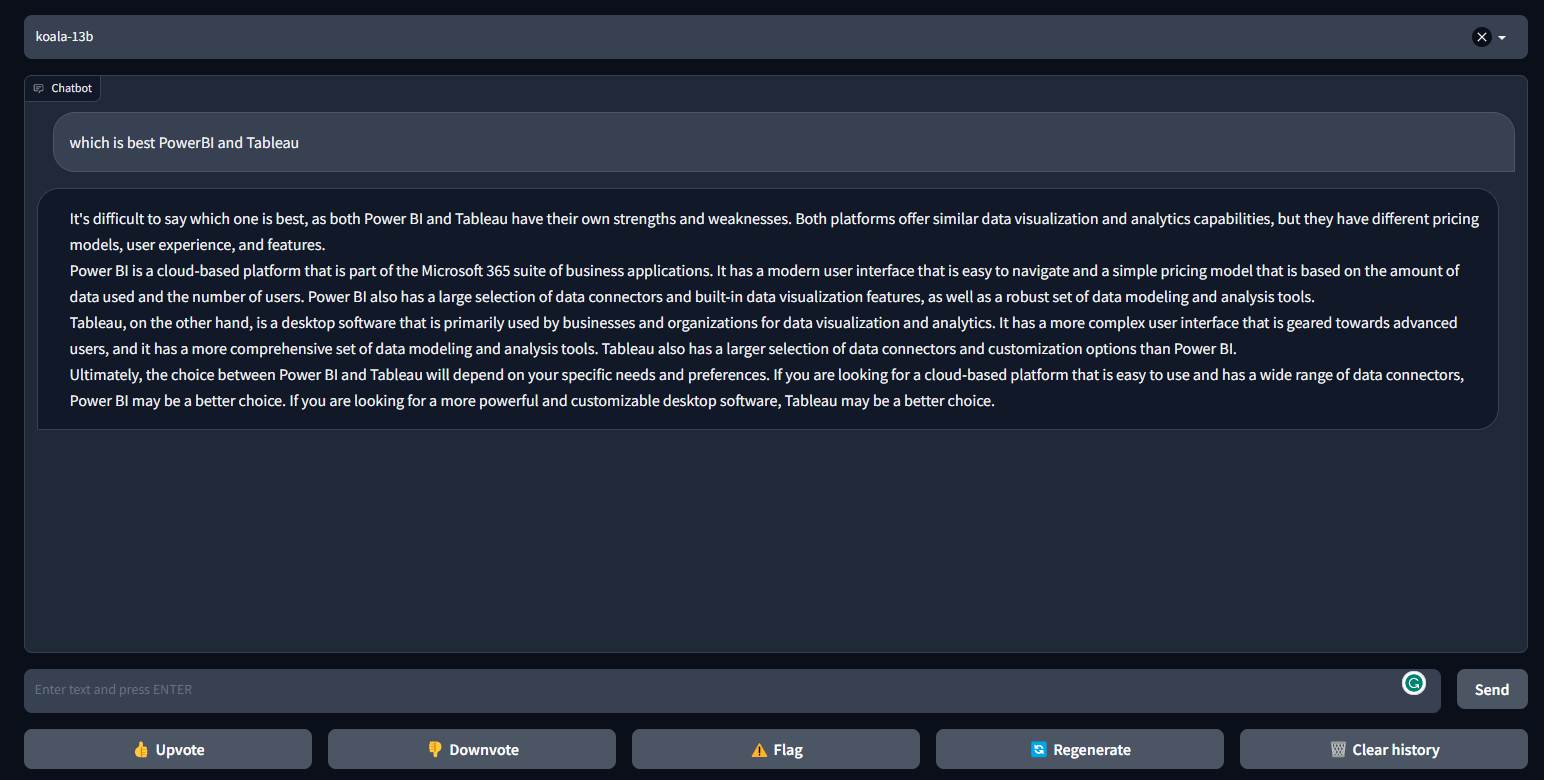

10. Koala

Koala es un chatbot entrenado ajustando LLaMa con un conjunto de datos de diálogo extraídos de Internet. Koala se ha comportado mejor que Alpaca y es similar a ChatGPT en muchos casos.

Koala proporciona código de entrenamiento, pesos públicos y sintonizador fino de diálogo, y fue evaluado por 100 humanos.

Imagen de FastChat/Koala

- Entrada del blog: Koala: Un modelo de diálogo para la investigación académica

- GitHub: young-geng/EasyLM

- Demo: FastChat/Koala

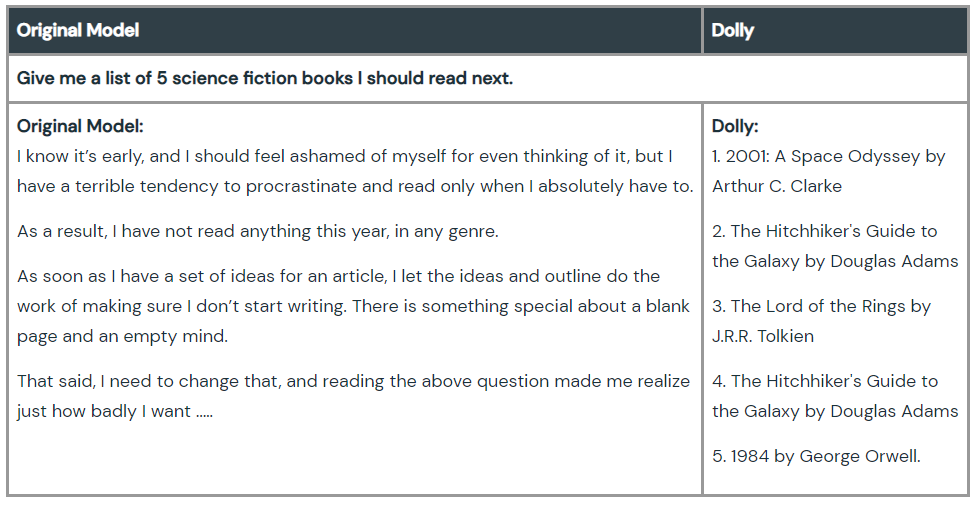

11. Dolly

Dolly es un gran modelo de lenguaje que fue entrenado por la máquina Databricks para demostrar que podemos utilizar el antiguo modo de lenguaje de código abierto y darle la capacidad mágica de seguir instrucciones de ChatGPT. El entrenamiento del modelo requiere 30 minutos en una máquina, utilizando datos de entrenamiento de alta calidad. Ni siquiera necesitas grandes modelos para conseguir una alta calidad. El equipo ha utilizado el modelo de 6000 millones de parámetros, frente a los 175 000 millones de GPT-3.

Echa un vistazo a Dolly 2.0, un modelo de lenguaje que sigue instrucciones y que puede utilizarse comercialmente.

Imagen de Hello Dolly

- Entrada del blog: Hello Dolly: Democratizar la magia de ChatGPT con modelos abiertos

- GitHub: databrickslabs/dolly

- Tarjeta modelo: databricks/dolly-v1-6b

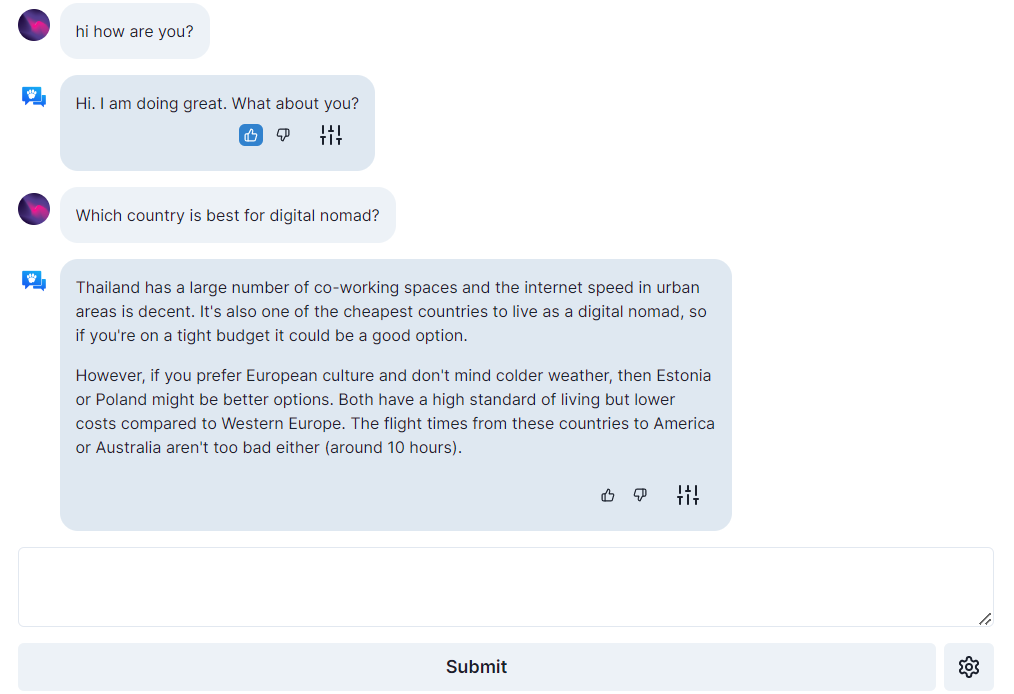

12. Open Assistant

Open Assistant es un verdadero proyecto de código abierto, lo que significa dar acceso a todo el mundo a los mejores modelos lingüísticos de gran tamaño basados en chat. Su objetivo es crear una revolución en la innovación del lenguaje permitiendo a las personas interactuar con sistemas de terceros, recuperar información de forma dinámica y crear nuevas aplicaciones utilizando el lenguaje.

Puedes ejecutar el gran chatbot lingüístico en una sola GPU de consumo de gama alta, y su código, sus modelos y sus datos tienen licencia de código abierto.

Imagen de open-assistant.io

- Entrada del blog: ¡Los primeros modelos de Open Assistant ya están aquí!

- GitHub: LAION-AI/Open-Assistant

- Demo: open-assistant.io

- Tarjeta modelo: OpenAssistant/oasst-sft-1-pythia-12b

Conclusión

Estas alternativas a GPT-4 pueden ayudar a investigadores, desarrolladores y pequeñas empresas a crear su tecnología basada en el lenguaje y competir con los gigantes del sector. El rendimiento de los modelos no está por encima de GPT-4, pero con el tiempo y la contribución de la comunidad, algunos podrían tener potencial para superar a GPT-4.

Si eres nuevo en ChatGPT, prueba a seguir nuestro curso Introducción a ChatGPT, y si conoces la IA generativa, puedes mejorar en los prompts revisando la completa Hoja de trucos de ChatGPT para la ciencia de datos, o consultando los recursos que aparecen a continuación.