Lernpfad

Die Methoden der KI haben sich im Laufe der Jahre stark verändert, und Trainingsdaten waren schon immer ein großes Thema beim Training von KI. Der Modellzusammenbruch ist deshalb ein wachsendes Problem bei generativer KI, wo Modelle, die mit ihren eigenen KI-generierten Daten trainiert werden, an Qualität verlieren und schließlich kaputtgehen, was zu einem erheblichen Verlust der Fähigkeit führt, die tatsächliche Datenverteilung darzustellen.

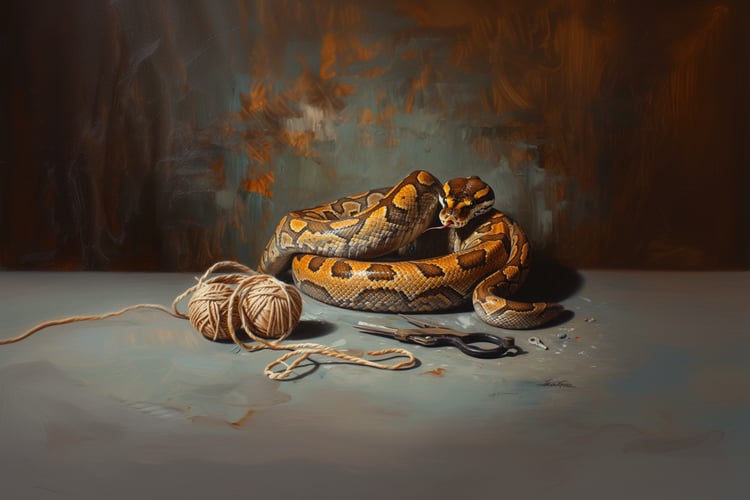

Das führt zu einer Art Teufelskreis, der die Qualität von großen Sprachmodellen runterzieht, die mit KI-generierten Inhalten trainiert werden – wir nennen das „KI-Kannibalismus”. In diesem Tutorial erkläre ich, was ein Modellzusammenbruch ist, warum er wichtig ist und wie man ihn verhindern kann.

Wenn du diese Konzepte genauer anschauen willst, empfehle ich dir den Karrierepfad „ Lernpfad „Associate AI Engineer for Developers”.

Was ist ein Modellzusammenbruch?

Modellkollaps ist ein echtes Problem beim Training im maschinellen Lernen, weil die Verwendung von synthetischen Daten zu einer zunehmenden Verschlechterung führt.

Modellkollaps ist, wenn ein Modell nicht mehr die ursprüngliche Datenverteilung richtig abbilden kann, was dann zu einheitlichen Ergebnissen führt. Es führt zu Selbstzerstörung, weil man sich zu sehr auf interne Daten verlässt, was oft als Modell-Autophagie-Störung (MAD) bezeichnet wird. Dieser zyklische Verbrauch von KI-Ergebnissen wird auch als KI-Kannibalismus bezeichnet.

Ein Modellzusammenbruch kann man schon früh erkennen, zum Beispiel wenn seltene Ereignisse oder Datenmuster von Minderheiten vergessen werden. Später sieht man dann, dass sich die Ergebnisse wiederholen und wenig abweichen, wie bei generischen Texten oder einheitlichen Bildern und so weiter. Warnzeichen sind zum Beispiel, dass Fehler öfter passieren, die Kreativität nachlässt und man sich immer mehr an Durchschnittswerten orientiert.

Der Zusammenbruch von Modellen ist wichtig, weil das Internet mit KI-generierten Inhalten wie chatGPT oder DALL-E überflutet wird. Das Risiko, dass Trainingsdatensätze mit künstlichen Daten wie KI-generierten Nachrichten, Artikeln, Fotos usw. verunreinigt werden, wird immer größer. Mehr über verschiedene Arten von Modellen erfährst du in unseren Kursen zu Was sind Foundation-Modelle? und Einführung in Foundation-Modelle.

Wie kommt es zum Zusammenbruch von Modellen?

Der Modellzusammenbruch kommt von den wiederholten Fehlern in der KI. In diesem Abschnitt erkläre ich die Mechanismen, die dahinterstecken.

Fehlerakkumulation

Es gibt viele Arten von Fehlern, die auftreten können, wie zum Beispiel funktionale Approximationsfehler, die man sich als die Unfähigkeit des Modells vorstellen kann, komplexe Funktionen perfekt anzupassen. Außerdem können Stichprobenfehler durch Verzerrungen aus endlichen oder unausgewogenen Datensätzen entstehen, sodass wir nicht unbedingt alle Aspekte des Datensatzes, einschließlich Ausreißer, berücksichtigen können.

Außerdem passieren beim Optimieren oft Fehler beim Lernen, wie zum Beispiel Verzerrungen beim Gradientenabstieg. All das kann echt zum endgültigen Verfall des Modells beitragen. Deshalb führt die Fehlerausbreitung zu einem Zusammenbruch in der frühen und späten Phase. Der Zusammenbruch in der Anfangsphase macht die Tail-Verteilungen kaputt. Das heißt, dass seltene Daten nach ein paar Durchläufen komplett vergessen wären. In der Zwischenzeit führt ein später Zusammenbruch zu einer totalen Gleichförmigkeit, wobei sich Fehler über mehrere Trainingsgenerationen hinweg wie ein Schneeball-Effekt verstärken.

Durch KI verursachte Datenverfälschung

Der Zusammenbruch von Modellen führt zu einem Verlust der Datenvielfalt. Das passiert, weil synthetische Daten häufige Muster überbetonen und seltene oder weniger häufige Muster (Ausreißer) ausblenden. Das führt zu verzerrten Modellen, die Randfälle ignorieren. Das kann zum Beispiel dazu führen, dass ein Diffusionsmodell bei jeder Iteration immer wieder die gleichen Muster erzeugt und nur stereotype Bilder produziert, was den Realismus und die Vielfalt verringert.

Ein weiteres Beispiel ist, wie LLMs aufgrund der begrenzten Datenverteilung, auf die sie abgestimmt sind, Nischenvokabular und kulturelle Nuancen verlieren. Wenn du mehr über verschiedene Möglichkeiten der Datenmodellierung erfahren möchtest, schau dir unsere Tutorials zu „ “ und „Multilevel Modeling“ an: Ein umfassender Leitfaden für Datenwissenschaftler und Datenmodellierung erklärt: Techniken, Beispiele und bewährte Verfahren.

Rekursive Trainingsschleifen

Der vielleicht gefährlichste Mechanismus für einen Zusammenbruch ist das rekursive Training. Wenn KI-generierte Ergebnisse immer wieder als neue Trainingsdaten verwendet werden. Das führt dazu, dass das System seine eigenen Fehler noch verstärkt. Es ist wie ein System, das sich selbst belohnt: Anstatt deine Fehler loszuwerden, bringst du dir bei, sie öfter zu machen, und deshalb nennen wir das „KI-Kannibalismus”.

Dieser Prozess ist wie eine verlustbehaftete Komprimierung, bei der in jedem Durchgang kleine Details wegfallen, bis die endgültigen Ergebnisse verschwommen und sich wiederholend sind. Über mehrere Generationen hinweg geht der ursprüngliche Wissensreichtum des Modells unwiederbringlich verloren.

Warum der Zusammenbruch von Modellen wichtig ist

Der Zusammenbruch von Modellen ist nicht nur ein technisches Problem, sondern hat auch große Auswirkungen auf Wissenschaft und Industrie, wie ich in diesem Abschnitt erklären werde.

Risiken für die Zuverlässigkeit und Innovation von KI

Der Zusammenbruch von Modellen gefährdet die Vielfalt und Zuverlässigkeit des globalen Wissensökosystems, weil er Vorurteilen und Fehlern mehr Bedeutung gibt als herkömmliche Trainingsprozesse. Dadurch besteht die Gefahr, dass ein Teufelskreis aus Fehlinformationen und Gleichförmigkeit entsteht, der das Informationsökosystem gefährdet.

Außerdem ist der Einsatz in Wissenschaft und Industrie echt hoch, weil Modelle, die seltene Muster nicht erfassen können, nicht reproduzierbar sind, was wiederum wissenschaftliche Entdeckungen verlangsamt. Außerdem kann es in Bereichen wie der Arzneimittelforschung, Klimamodellierung oder Finanzprognosen zu teuren Fehlern, Verzögerungen und damit zu einem Vertrauensverlust kommen.

Wie man verhindert, dass das Modell zusammenbricht

Um Zusammenbrüche zu vermeiden, braucht's eine Mischung aus Datenpraktiken, menschlicher Aufsicht und hybriden Trainingsmechanismen. In diesem Abschnitt werde ich das genauer erklären.

Methoden zur Datenvalidierung

Die Grundlage sind hochwertige, von Menschen erstellte Daten. Deshalb sollte die Validierung kontaminierte Proben in den Daten erkennen und herausfiltern, damit der Trainingsprozess auf echten Daten basiert. Mehr über Datenmodellierungstools erfährst du in unserem Blog „ “ (Die 19 besten Datenmodellierungstools für 2025): Funktionen und Anwendungsfälle.

Menschliche Aufsicht und Eingriffe

Mensch-im-Loop-Systeme sind echt wichtig, um die Daten korrekt zu halten, weil immer ein Mensch eingreifen und schauen sollte, ob irgendwelche Verzerrungen auftreten.

Wenn du zum Beispiel einen chemischen LLM-Experten mit verunreinigten Daten trainierst, kannst du feststellen, dass die synthetischen Daten voller gängiger Verbindungen wie Formaldehyd oder anderen sind, was zu einem Modell führt, das sich besonders gut mit dieser Verbindung auskennt, aber absolut nichts über seltene Verbindungen weiß.

Deshalb können Experten die Ergebnisse checken, Verzerrungen korrigieren und wieder mehr Vielfalt in die Datensätze bringen. Mechanismen zur Korrektur von Verzerrungen sind auch wichtig, um Minderheiten und seltene Fälle zu schützen. Es gibt natürlich viele Möglichkeiten, das Lernen großer Sprachmodelle zu verbessern, entweder durch Training oder durch bessere Nutzung. Schau dir unser Tutorial zum Model Context Protocol (MCP) von „ “ an: Ein Leitfaden mit Demo-Projekt und unser Blog auf Große Konzeptmodelle: Ein Leitfaden mit Beispielen.

Hybride Trainingsansätze

Echte Daten sind echt rar und brauchen viel mehr manuelle Arbeit. Deshalb kann es echt schwierig sein, nur echte, hochwertige Daten zu haben. Wir können aber echte und synthetische Daten zusammen nutzen, was den Prozess effektiver macht, als wenn wir die eine oder andere Variante weglassen würden. Wenn man es richtig macht, kann man mit Hybrid-Training die Vielfalt behalten und gleichzeitig von der Skalierbarkeit synthetischer Inhalte profitieren.

Algorithmische und architektonische Neuerungen

Technisch gesehen haben Forscher Methoden entwickelt, um dem Zusammenbruch entgegenzuwirken. Diese Methoden lassen sich hauptsächlich in zwei Arten einteilen:

- Architektonische Lösungen wie Minibatch-Diskriminanz, die Vielfalt fördert, indem sie das Modell Proben innerhalb eines Batches vergleichen und zu ähnliche Ergebnisse bestrafen lässt, ungerollte GANs, die das Training durch die Simulation zukünftiger Optimierungsschritte stabilisieren, und spektrale Normalisierung, die die Lipschitz-Konstanten der Schichten einschränkt, um das Training zu stabilisieren.

- Algorithmische Methoden einschließlich KL-Divergenz Annealing, das nach und nach die Balance zwischen Erkundung und Genauigkeit findet, PacGAN, das mehrere gepackte Samples im Diskriminator nutzt, um Modellkollaps zu erkennen und zu verhindern, und andere Regularisierungsansätze, die das Training stabilisieren und die Vielfalt erhalten.

Es gibt noch viele weitere Innovationen zu entdecken. Schau dir unsere Tutorials zu „ “ und „Multicollinearity in Regression“ an: Ein Leitfaden für Datenwissenschaftler und Strukturgleichungsmodellierung: Was es ist und wann man es benutzt.

Zukunftsaussichten und praktische Überlegungen

Da KI-generierte Inhalte immer mehr überall zu finden sind, wird das Risiko von Modellzusammenbrüchen immer größer.

Sich entwickelnde Risiken mit KI-generierten Daten

Die Menge an synthetischen Daten im Internet wird immer größer, was die Wahrscheinlichkeit einer Modell-Autophagie-Störung erhöht, die einfach dadurch entsteht, dass das Modell seine eigenen Ergebnisse verbraucht. Wenn das so weitergeht, kann es zu rekursiven Schleifen kommen, die dann den Verfall des generativen Modells verursachen.

Die Lösungen für den Zusammenbruch von Modellen können nicht nur auf technischen Details basieren. Ein guter Plan sollte gute Rahmenbedingungen für die Steuerung und ein paar bewährte Methoden haben, damit die KI-Entwicklung verantwortungsvoll läuft. Außerdem braucht's dafür globale interdisziplinäre Maßnahmen, um den Zusammenbruch von Modellen zu verhindern, nicht nur Ingenieure aus der Industrie. Es braucht die Zusammenarbeit von Forschern, Politikern, Ethikern und so weiter, um die öffentlichen Infos zu schützen.

Fazit

Der Zusammenbruch von Modellen ist eine der größten Gefahren für die Zuverlässigkeit und den Nutzen generativer KI in der Zukunft. Das liegt hauptsächlich an rekursiven Trainingsschleifen, Fehlern, die sich auf alle möglichen Arten ansammeln, und Datenverfälschungen.

Für die Zukunft liegt der Weg zur Prävention in der Datenverwaltung, Innovation und menschlichen Aufsicht. Die Verantwortung dafür liegt nicht nur bei den Labors, sondern auch bei Politik und Verwaltung.

Deshalb sollten Forscher und Entscheidungsträger den Fokus auf hochwertige, von Menschen erstellte Daten legen, wobei sie einen gewissen Kompromiss mit synthetischen Daten eingehen und Schutzmaßnahmen in KI-Pipelines einbauen müssen. Nur so können wir dafür sorgen, dass Daten fair verteilt und zuverlässig sind, um am Ende das volle Potenzial von KI für die Zukunft auszuschöpfen.

Häufig gestellte Fragen zum Modellzusammenbruch

Was ist der Unterschied zwischen einer gestörten Autophagie und Kannibalismus bei KI?

Beide beschreiben dasselbe Problem, dass Modelle schlechter werden, wenn sie mit ihren eigenen Ergebnissen trainiert werden. Modell-Autophagie-Störung ist der Fachbegriff dafür, während KI-Kannibalismus ist eher eine bildliche Beschreibung.

Was führt zum Zusammenbruch von Modellen in der generativen KI?

Modellzusammenbrüche passieren wegen Fehleransammlungen, Verfälschungen durch KI-generierte Daten und sich wiederholenden Trainingsschleifen, die Verzerrungen verstärken und Vielfalt wegnehmen.

Warum ist der Zusammenbruch von Modellen heutzutage ein immer größeres Problem?

Da das Internet immer mehr mit KI-generierten Inhalten voll ist, ist das Risiko, dass zukünftige Modelle mit synthetischen Daten trainiert werden und dadurch zusammenbrechen, größer denn je.

Wie kann man verhindern, dass Modelle zusammenbrechen?

Um Probleme zu vermeiden, muss man hochwertige menschliche Daten, menschliche Überwachung, hybride Trainingsstrategien und algorithmische Schutzmaßnahmen wie PacGAN oder spektrale Regularisierung kombinieren.

Was sind die Risiken eines Modellzusammenbruchs für reale Anwendungen?

Modellversagen kann die Zuverlässigkeit in wichtigen Bereichen wie der Arzneimittelforschung, Klimamodellierung und Finanzwelt gefährden, wo schlechte Ergebnisse zu teuren Fehlern und Innovationsstaus führen können.

Ich arbeite an beschleunigten KI-Systemen, die Edge Intelligence mit föderierten ML-Pipelines auf dezentralen Daten und verteilten Workloads ermöglichen. Meine Arbeit konzentriert sich auf große Modelle, Sprachverarbeitung, Computer Vision, Reinforcement Learning und fortgeschrittene ML-Topologien.